第429回:シンポジウム 「歌声情報処理最前線! 」レポート その2

~オープンソースの歌声合成や、“オンチ補正”システムなど ~

|  |

| 歌声情報処理最前線! の様子 | |

前回に続き、今回も7月28日に行なわれた情報処理学会・音楽情報科学研究会による第86回目となる研究発表会=シンポジウムのスペシャルセッション「歌声情報処理最前線! 」を紹介する。

全部で9つの発表があったうち、前回は産業技術総合研究所の3つの発表を取り上げたので、それ以外の6つを紹介していこう。

■ オープンソースの歌声合成システム「Sinsy」

まず最初は、名古屋工業大学大学院・工学研究科の大浦圭一郎氏と、徳田恵一教授がプレゼンテーションを行なった「Sinsy: 『あの人に歌ってほしい』をかなえるHMM歌声合成システム」。今はまさにVOCALOID時代であり、初音ミクの大ヒット以来、さまざまな製品が登場し、多くのユーザーが利用し、ニコニコ動画などの投稿サイトが盛り上がっている。

最近では、これらのVOCALOIDが歌った曲がCDにもなっているほどだが、歌わせるソフトはVOCALOIDだけではない。以前作者にインタビューをした「Aques Tone」や、「UTAU」、またVOCALOID用のVSQファイルを編集できる「Cadencii」といったものもあり、歌声合成といったこと自体の認知度も高まっている。そんな中、名工大が打ち出した歌声合成システムが「Sinsy」すでに、Web上で一般公開されているため、誰でも利用可能なシステムとなっている。

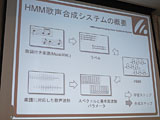

ここで利用されているのが名工大で2002年に作り出された「HMM (Hidden Markov Model:隠れマルコフモデル)歌声合成システム」というものだ。これは以前からあった「HMMテキスト音声合成」技術をベースに歌声用に応用したもので、VOCALOIDのように波形を保持するシステムではないため、小さなメモリ容量で動作するのが大きなポイント。また、さまざまな歌声を合成することが可能となっている。さらにベタ打ちのみで動作させるため、調教作業が不要というのも大きな特徴となっている。そしてオープンソースとしても公開されている。

|  |  |

| 名古屋工業大学大学院・工学研究科の大浦圭一郎氏(左)と徳田恵一教授(右) | Sinsy | HMM歌声合成システム |

|

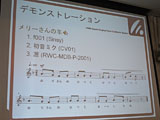

| 初音ミクと実在の女性の声に似せて歌うデモが行なわれた |

これを誰でも簡単に使える形にしたSinsyでは、楽譜データをサーバー側に渡すことで歌声合成を行ない、WAVが生成される。ユーザーはこれを再生したりダウンロードすることができる。楽譜データとはMusicXMLという広く使われている形式で、CadenciiやMuseScoreといったフリーウェアで生成できるほか、CubaseやFinaleといった市販のソフトでも利用可能となっている。ここに音符と歌詞を入力しておけば歌ってくれるので、興味のある方は試してみるといいだろう。

そしてHMM歌声合成システムだからこそできるユニークなことが、話者適応。これは目標の声質にモデルを近づける手法であり、声質・歌い方を真似ることができ、しかも少量のデータでも動作するようになっている。会場では、初音ミクと実在の女性の声に似せて歌うデモが行なわれたが、確かに似た感じになっていた。

現在公開されているWebページでは、別の声に似せるところまではできないが、今後ユーザー独自の歌声をアップロードすると、その声に似た歌声を合成できるようにしていくという。

■ 歌詞に合わせて自動で作曲して歌う「Orpheus」

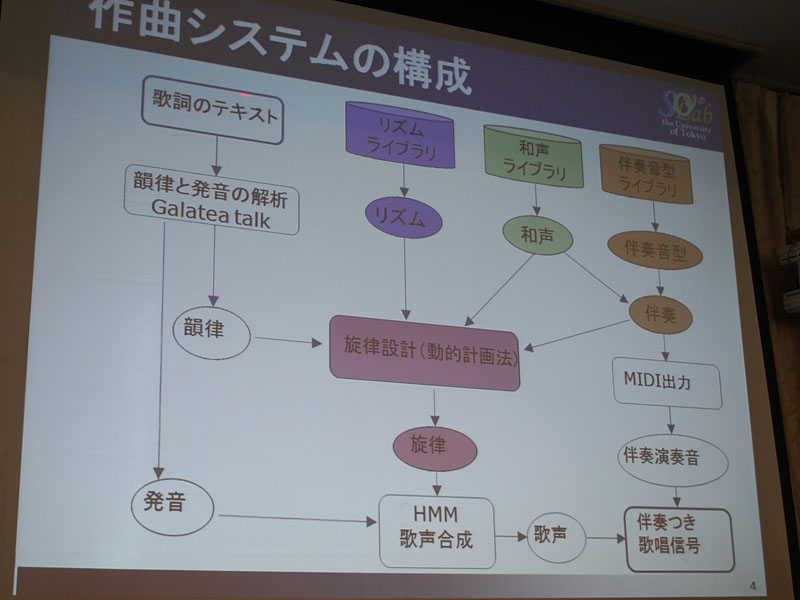

次は東京大学・情報理工学系研究科の深山覚氏による「歌唱曲自動作曲の需要と今後-2年間のOrpheus運用を通じて」。これもまたユニークな技術発表だが、Orpheus(オルフェウス)を一言でいえば、歌詞を与えると自動的に作曲して歌うというもの。これまでもテレビのバラエティー番組などで何度か紹介されているので、ご覧になった方もいるかもしれない。

デキの良し悪しは別として、自動的に作曲するツールというのはこれまでにもいろいろあったが、Orpheusですごいのは、歌詞の韻律にもとづいたメロディーが作られるという点にある。たとえば、「まっかだな、まっかだな、つたのはっぱがまっかだな」という歌詞にあのメロディーがついているわけだが、「まっかだ」という部分だけを考えてみよう。

普通に文字として読んだ場合、「か」のイントネーションが高い音になるのに気づくはずだ。メロディーもそれにしたがって「か」の音が高くなっているが、同様のことが「はっぱ」などさまざまな言葉にも適用されている。もし、メロディーで反対のイントネーションになっていると気持ち悪いし、聞いていても意味が分からなくなる可能性が高い。また音の高低だけでなく、音の強弱、長短といったことも重要な要素となる。実際、作詞・作曲する際、こうした歌詞の韻律を考えて行なうケースも多いと思うが、それを自動的に行なうのがOrpheusなのだ。

|  |

| 「歌唱曲自動作曲の需要と今後-2年間のOrpheus運用を通じて」を発表した東京大学の深山覚氏 | 古典的な書法の作曲における特徴 |

Orpheusでの歌声はSinsy同様HMM歌声合成が採用されているが、伴奏パートもいっしょに自動作曲されるのも面白いところだ。現在、OrphuesはWeb上でも一般に公開されており、誰でも簡単に作曲できるので、試してみると面白い。ロック、ボサノバ、童謡といったジャンルを選択するとともに、歌声を男性か女性かを設定、そしてテンポを指定した上で歌詞を入力すれば、約20秒ほどで作曲されてMP3が生成される。歌詞はひらがな、カタカナだけでなく漢字も認識して読んでくれるので、いろいろ歌わせてみるといいだろう。

|  |

| 伴奏パートもいっしょに自動作曲される | ジャンルや声の種類、テンポを設定して歌詞を入力するとMP3が生成される |

■ カラオケで「オンチ」をリアルタイム補正する技術

次は立命館大学・情報工学部の森勢将雅助教による「実時間歌唱力補正に基づく新たなカラオケエンタテインメントの創出」という発表。デモで最初に流れたのは、カラオケにのった並外れたオンチで酷い歌。森勢氏のシステムを使うと、リアルタイムにそのオンチを補正してくれるというのだ。実際、その結果は、かなり上手な歌に変化していたが、これをリアルタイムでこなすというのだから、すごい。

ここでは予め歌が上手い人が歌ったお手本=テンプレートを用意しておき、そこから「歌唱力」に相当するパラメータを抽出し、下手な人に当てはめる、という流れになっている。つまり上手い人は、それを提供する楽しみを、下手な人は努力しなくても、さまざまな上手い人の歌い方を実践できる楽しみが得られるという。

リアルタイム処理だけに、歌うタイミングだけは、お手本と合わさなくてはならないというネックはあるようだが、これがカラオケで本当に使えたら嬉しい人も多そうだ。

ここでは、入力されたオンチな歌声からピッチ(基本周波数)、音色(スペクトル包絡)、擦れの程度(非周期性指標)の主に3つのパラメータを抽出し、それをテンプレートにしたがって再合成をする仕組みとなっている。これはSTRAIGHTという技術によるものだ。まだ、発展途上の段階であり、現在のバージョンは0.0.3。とはいえC言語によるソースコードも含めて研究内容はフリーで公開されているので、カラオケ機器メーカーのエンジニアの方など興味のある方はチェックしてみるといいかもしれない。

|  |  |

| 「実時間歌唱力補正に基づく新たなカラオケエンタテインメントの創出」を発表した立命館大学・情報工学部の森勢将雅助教授 | 歌が上手い人によるお手本を用意し、そこから「歌唱力」に相当するパラメータを抽出、下手な人に当てはめる | 「STRAIGHT」技術の内容 |

|

| 「歌声を見て触る: TANDEM-STRAIGHTと時変モーフィングが提供する基盤」を発表した和歌山大学の河原英紀教授 |

さて、その次の全体では6番目になる発表は和歌山大学・システム情報学センター長である河原英紀教授による「歌声を見て触る: TANDEM-STRAIGHTと時変モーフィングが提供する基盤」というもの。前回の産総研の発表も含め、歌声を処理する技術としてSTRAIGHTというものがキーワードのように何度も登場してきていた。これは何なんだろう? と思っていたが、河原教授が1997年に作り出した、まさに歌声情報処理の根幹を支えるような技術だ。

理論的なことは難しくて、筆者には説明できそうにないが、STRAIGHTを利用することで、話声を歌声に変換することができるほか、声色を変換することも可能。つまり同じ歌であっても、嬉しく歌った声、哀しく歌った声、怒って歌った声といった異なる声色へと変換できるのだ。さらに、喜怒哀の感情を混ぜることができるのも面白いところ。音量的にミックスするというのではなく、喜から怒へと徐々にモーフィングさせることを可能にする技術なのだ。

STRAIGHTもどんどんと進化し、2007年には先ほどの森勢氏が作り出したTANDEMという技術も取り入れたTANDEM-STRAIGHへと発展している。このTANDEM-STRAIGHTで何ができるかは、ネット上で公開されているムービーを見るのが一番分かりやすい。あるフレーズに対してF0=音高を自在に変化させることができるほか、音量、長さ、フォルマントなどを自在に、そしてキレイにスムーズに変化させることができるようになっている。まさに歌声を見て触る技術である。

こうした基幹技術が大学で生まれ、このような学会で発表・公開されるとともに、ほかの研究機関やメーカーへと広がっていく。まさに学会の意義、あるべき姿の理想形を見たような気がした。

|  |  |

| 同じ歌でも、嬉しく歌った声、哀しく歌った声、怒って歌った声など異なる声色へ変換できる | 喜から怒へと徐々にモーフィングさせることも可能 | STRAIGHTからTANDEM-STRAIGHへと進化 |

■ 「歌声を話声に変換する」合成システムなども

全体で8番目の発表となったのは京都大学・工学部情報学科の阿曽慎平氏による「SpeakBySinging: 歌声を話声に変換する話声合成システム」。歌声を別の歌声へと変換したり、話し声を別の話し声へと変換する、また、話声に楽譜情報を与えて歌声へと変換する「SingBySpeaking」という技術はこれまでもあった。まさに先ほどのSTRAIGHTもそうだ。それに対し、阿曽氏はこれまでにほとんど行なわれていなかった歌声を話声に変換するシステムに取り組んでいる。

|  |

| 「SpeakBySinging: 歌声を話声に変換する話声合成システム」を発表した京都大学の阿曽慎平氏 | 歌声を話声に変換する |

「でも、それって何か役に立つの? 」と素朴な疑問を持ったのだが、阿曽氏は、「話声と歌声がまったく異なる人がいる。そして、歌声に大きな魅力を持つ人もいるので、その歌声を利用して、話声に変換すれば、まさに声優のような感情あふれる魅力的なものになるはずだ」というのだ。デモでは、阿曽氏自身の話声からは想像できないオペラ歌手のような歌声が披露されていたが、それを元に話声に変換すると、プレゼンテーションにおける阿曽氏の話声、話し方とはまったく異なる感情こもった話声が生成されたのである。

基本的な流れとしては、まず歌と普通のしゃべりでは時間が異なるので、通称の話し方と同等になるように時間伸縮を行ない、タイミングを合わせる。さらに声の高さ=F0を話声として違和感がない変換させる。そして、最後に音の強さを話声になるように増減することで実現しているとのこと。

ただし、歌声の特徴を抽出するための前処理として、歌声とともに歌詞も入力しておく必要がある。その歌詞を元に音韻長を抽出した上でSTRAIGHTを利用して、F0やパワーを分析しておくのだ。さらに歌詞からTTS(Test to Speach)を利用することで、話し声としての音韻長とF0、そしてパワーを予め求める。これら前処理したデータを利用して、歌声の特徴を生かしつつ、話声に変換するというわけだ。

|  |

| 変換のイメージ | 処理の概要 |

実際、どんなシーンで利用できるものなのかは想像するのは難しいが、大学ではいろいろな研究が行なわれているのだなと感心した。

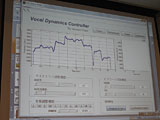

最後のプレゼンテーションは唯一の企業からの発表。NTTのNTTコミュニケーション科学基礎研究所の大石康智氏による「Vocal Dynamics Controller: 歌声のF0動特性をノート単位で編集、合成できるインタフェース」だ。歌声のF0動特性、つまりピッチの変化をノート単位で編集することで、歌い方をいろいろと変換できるようにするシステムだ。ピッチが外れているものを正しいピッチに補正したり、音階そのものを変えるだけでなく、ひとつのノート内での音程変化を調整したり、ビブラートをかけるといったことを可能にするものだ。

|  |

| NTTコミュニケーション科学基礎研究所の大石康智氏 | Vocal Dynamics Controllerの画面 |

というところまでは何となく分かったものの、そこから先は、難しい数式のオンパレードで、残念ながら筆者にはまったく理解することができなかった。Antares Audio TechnologiesのAuto-TuneやRolandのVariPhraseテクノロジなど商用製品においても、似た発想のものがいろいろあるが、アルゴリズムや考え方の部分でいろいろな違いがあるのかもしれない。興味のある方は、発表されている論文を見たり、この発表を録画したニコニコ動画やUstreamのアーカイブをご覧いただけたらと思う。

以上、2回に渡って情報処理学会・音情研の「歌声情報処理最前線! 」の発表内容を紹介した。 学会というと、とにかく難しく堅いイメージがあるが、それとはかなり違う楽しいシンポジウムだったことは新鮮な驚きだった。また、発表者が若い人ばかりで、集まっている人も若い人が中心というのも従来の学会のイメージと大きく異なるところ。歌声合成はVOCALOIDを中心に、まさに多くの人たちの関心を集める技術分野。ぜひ、ここから日本発のすごい技術が次々と生まれてきてくれることを期待したい。