第522回:人の歌声をボカロが真似る「ぼかりす」ついに発売

~産総研とヤマハが語る「VocaListener」開発の道のり ~

|

| 「VocaListener(ぼかりす)」の画面 |

VOCALOIDの世界では、だいぶ以前から話題になっていた衝撃的なVOCALOID調教ツール「ぼかりす」なるものが、いよいよ10月19日にヤマハから19,800円で発売されることが決まった。「ぼかりす」は、どうしても機械っぽいニュアンスになりがちなVOCALOIDの歌声を、滑らかな人間っぽいものに仕上げることができるというユニークなソフトウェア。「VocaListener(ボーカリスナー)」というのが正式名称だが、これを開発したのは産業技術総合研究所(以下、産総研)、という日本国内最大級の公的研究機関。

産総研は音楽に関連したさまざまな研究開発でも知られている。例えば最近も「Songle(ソングル)」で話題になったばかりである。世界最先端の研究成果が製品として登場するのは、VOCALOIDユーザーにとっては、待ちに待ったツールがようやく登場といった感じかもしれない。

その「ぼかりす」発売に先駆けて、「ぼかりす」を研究開発した産総研の情報技術研究部門 上席研究員の後藤真孝氏と同部門 研究員の中野倫靖氏、そして「ぼかりす」の製品化を行なったヤマハのyamaha+推進室 Y2プロジェクト 技師の大島治氏の3人にいろいろと話を伺ってみた(以下、敬称略)。

|  |

| 今回インタビューを行なった後藤、中野、大島の三氏 | 産総研 情報技術研究部門 上席研究員の後藤真孝氏 |

|  |

| 産総研 情報技術研究部門 研究員の中野倫靖氏 | ヤマハのyamaha+推進室 Y2プロジェクト 技師の大島治氏 |

■ 鏡音リン・レンの発売が後押しした「ぼかりす」の構想

――最初に「ぼかりす」で初音ミクを調教した曲、「PROLOGUE」を聴いたときには、本当に驚きました。まさか、これがVOCALOIDによる歌だとは思えないほど自然な歌声でしたから…。でも、そもそも「ぼかりす」はいつごろ、どんなキッカケで生まれたのですか?

|  |

| PROLOGUE(ニコニコ動画:Zero) | PROLOGUE(YouTube) |

後藤:話をすると、ちょっと長くなるのですが……。初音ミクが発売された2007年8月31日、VOCALOID開発者であるヤマハの剣持秀紀さんもいっしょにベルギーのアントワープで行なっていた国際会議、Interspeech 2007に出席していました。ちょうど目の前で日本との国際電話を切ったばかりの剣持さんから、「後藤さん、初音ミクが発売日に店頭で売り切れましたよ!」と言われて、「帰国したら我々もすぐに購入しなくては」と思ったのがそもそもの始まりでした。それ以来ずっと、ネットの盛り上がりには注目していたのです。我々としても、歌声に関する音楽情報処理の研究を長年してきたので、この盛り上がりに何か貢献できればと考えていました。

中野:そのころ、私は筑波大学の博士後期課程の3年生でしたが、すでに以前から後藤さんと共同で研究をしていました。インターンシップという形で産総研に日々通って、いろいろな議論をしていたのです。

後藤:2007年9月から12月にかけてVOCALOIDを用いたいろいろな作品を中野君と日々追いかける中で、より人間らしく自然に歌声を合成しようとしてパラメータを調整している人たちの努力がよくわかりました。「それだったら人間の歌唱を自動的に真似て歌声合成すればもっと自然になる!」と、12月には中野君と一気に「ぼかりす」の研究構想を生み出していました。まだ「ぼかりす」という名前は付けていませんでしたが、何度も反復してパラメータを調整するアイディアも同時に生まれていました。

そうこうしているうちに、12月末に鏡音リン・レンが発売されました。予想通り、初音ミク用に調整したVSQファイルを鏡音リン・レンに読み込ませると違う表現になってしまい、また一から調整しなくてはならない。1回目はともかく、歌声の声質を変えたいだけなのに全部の作業をやり直すというのはさすがに大変で、「これは我々の研究構想をますます実現しなければならない!」と確信したのです。

――なるほど、リン・レンの発売が、「ぼかりす」開発を後押ししたわけですね?

中野:そうですね。ちょうどそのころ、博士論文を書きながらも、初音ミク周辺の盛り上がりに熱中していて、次の研究テーマとして「人間の歌唱を真似て歌声合成しよう!」と後藤さんと盛り上がっていたので、早く着手したくてうずうずしていました。そんなとき後藤さんから「クリスマスプレゼントだ」といって鏡音リン・レンのパッケージを手渡され、これはもうやるしかないな、と。音符を1つずつ入力していくのは、それなりに音楽的な知識がいるけれど、カラオケなら誰でも歌えるので、そうした入力方法があればもっと多くの人が手軽に使えるに違いない、と使命感を感じていました。

――中野さんは、大学ではどんな研究をされていたのですか?

|

| 学会で発表した当初の「ぼかりす」 |

中野:筑波大学の図書館情報メディア研究科の学生だったのですが、指導教官の専門が音楽情報処理であったため、歌声の分析について研究していました。例えば、「ドン・タン・ド・ド・タン」と口で歌うと、それを認識して楽譜にしてくれる口ドラム認識システムを作りました。そのころから後藤さんとずっと一緒に研究をしていて、ここで培った技術の一部も「ぼかりす」実現に役立っています。また歌唱力評価に関する研究も行ないました。カラオケマシンには、楽譜に忠実に歌っているかを元にして採点をする機能がありますが、採点結果は必ずしも人間の感じる上手さとは一致しません。人間は、ほかの評価軸でも見ているんですね。

そこで楽譜なしで判断できるように、声の高さの相対変化やビブラートに着目して、歌唱力を評価するシステムを実現しました。さらに博士後期課程の最後では、「ブレス検出」という研究もしていました。人は歌っているときに息継ぎをしますが、それを自動的に検出するとともに、ブレスにどんな特徴があるのかなどを判断するものです。こうした歌声に関する研究成果の蓄積が「ぼかりす」研究のベースとなっていて、「ぼかりす」自体の実装は短期間で一気にできました。

後藤:研究では、大きく3つのことが重要になります。まず第一に、問題発見。何を研究すべきかというテーマ探しですね。第二に、問題解決。発見した問題を解く上で、最先端の技術を自ら研究開発し、解決していくわけです。しかし、いくら優れた研究成果を出しても他の人に伝えなければ、自己満足にすぎません。そこで第三に、成果発表。つまり、他の人が再利用可能な知見となるように、わかりやすく発表するのも非常に重要な研究者の使命です。そこで、我々は「ぼかりす」の発表に関してちょっとユニークな手段をとってみたのです。

■ お手本を真似した合成歌声をさらに分析。修正を繰り返し人の声に近づける

――ユニークな手段とはどんなことですか?

後藤:2008年の5月28日に、神戸の音楽情報科学研究会で学会発表する予定だったのですが、「ぼかりす」の研究成果を広く知ってもらうために、その1カ月前にニコニコ動画に投稿をしたのです。それが、初音ミクの「PROLOGUE」の動画です。本名で投稿する人がほとんどいなかったので、我々もニコニコ動画での流儀にしたがって、「ぼかりす」というペンネームで投稿しました。また投稿したときのメッセージとしては「この調教結果を聞いてみて頂けますか?まだちょっと不自然なところがあるのですが、楽しんで頂ければ幸いです」とありのままの気持ちを書いて……。

中野:ニコニコ動画には、普段から初音ミクの曲を聴いていて、世界で最も歌声合成の表現に敏感な視聴者がたくさんいるわけです。その方々がどう感じるかを知りたい気持ちもありました。最初は話題にならず埋もれるのでは……と思っていたので、その日の夜からすごい反響があって驚きました。ただ、最初のうちは歌声自体を楽しんでくれていたのですが、だんだん「どうやっているんだ?」「誰がやっているんだ?」という雰囲気になって、早くも翌日には我々がやっているに違いないと書かれるようになりました。

――なぜそんなに簡単に特定されてしまったのですか?

後藤:ペンネームで投稿したとはいえ、当然学会発表もするわけですし、隠し通そうと思っていたわけではありません。他の研究者に矛先が向いて迷惑をかけないためにも、いろいろと足跡は残して、いずれ分かるようにはしていました。が、まさか、これほどすぐにバレるとは思いませんでした。実は、ここでデモに使った「PROLOGUE」は、私が中心になって2001年に作った研究用音楽データベースに収録されていて、音楽情報処理の研究者の多くが知っている曲でした。そこで、このオケを持っているとしたら産総研に決まっている、しかも投稿者が「ぼかりす」であり、5月の学会では「VocaListenerなるものが発表される」というのもあって、翌日には特定されてしまったわけですね(笑)。

――ネットの人たちの情報収集能力というのは、すごいですね。

後藤:ただ、それ以上に興味深かったのは、ネット上での「ぼかりす」に関する賛否両論の議論です。我々もまったく予想していなかった論点がいろいろと出ました。一番予想外だったのが、「ミクっぽくない」という反応が多かったことです。自分にはミクの声にしか聞こえていなかったので。Genderパラメータを90にして、やや大人っぽい声だったのも影響していましたが「VOCALOIDらしさとは何か」という議論が深まりました。一方、誰も知らなかった潜在能力を引き出した、と高く評価する反応もあり、嬉しかったです。

――ここで改めて、「ぼかりす」とはどんなシステムなのか、簡単に解説していただけますか?

|

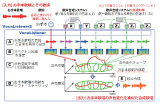

| 「ぼかりす」の概念図 |

中野:「ぼかりす」は、人が歌った歌声を分析し、それとほぼ同じ歌い方をするVOCALOID用のデータを作り出すシステムです。人の歌声をお手本として、その声の高さと大きさを真似るように合成します。初音ミクだけでなく、MegpoidでもVY1でも、どんなシンガーであってもそれに合わせて動作するようになっているのも大きな特徴です。

システムの流れとしては、まず、歌声を分析して、歌詞の文字がどの時刻に対応するのかを特定します。次に人間の声から声の高さと大きさを分析し、VOCALOIDのパラメータに置き換えて合成します。ただ、ここで「ぼかりす」の大きなポイントとなっているのは、VOCALOIDで合成した歌声を再度分析するということ。うまく真似できるようになるまで、何度もパラメータを修正していく、という反復的な処理をしているのです。

従来の歌声合成は合成したら、しっぱなし。一方「ぼかりす」では、システム自身がどう歌っているかを自覚しながら、合成していく。どんなふうに音が出ているかをちゃんと聴いて確認するシステムになっています。だから、VocaListenerと名付けました。

――なるほど、なんでVocaListenerという名前なのか、ちょっと不思議に思っていましたが、そんな秘密があったんですね!

中野:はい、「お手本のボーカルをリッスンして真似る」、「自分の合成した歌声をリッスンしながらさらに真似る」という二つの意味を込めました。さらに、調べてみると「vocalis(ぼかりす)」には医学用語で声帯という意味もありました。

後藤:このような合成した歌声を再度、聴いて分析するというのが、さっきの「ミク用VSQがリン・レンで違う表現になる」問題につながるのです。つまり、同じパラメータを与えただけでは、シンガーによって違いが出てしまうけれど、このような反復的に調整するシステムにすると、そうした違いを吸収することができるわけです。

でも、そもそも、なぜシンガーによって違いが出てしまうのか。これは、VOCALOIDの仕組みとして、人間の声を録音し、その声の素片を切り貼りするシステムとなっているからです。もともとの声の素片の高さは必ずしもジャストではありません。微妙に揺らいでいるし、音量も揺れています。シンガーによって声の素片が違うので、同じパラメータを与えても結果が違うのは当然。また、前後にどの歌詞の文字をつないだかによっても影響を受けてしまいます。

だからこそ、合成した歌声が思い通りに歌えているかをチェックすることで解決しているわけなのです。もちろん、素片によってはどう合成しても似た歌い方にならないケースはあります。それでも「ぼかりす」は何度も歌い直して、少しでも近づくように努力しているんですね。

■ ヤマハから「ぼかりす」が発売されるまで

――なるほど、「ぼかりす」とはそんなすごいシステムになっていたんですね。ところで、2008年4月28日のときの騒動、大島さんはご存知だったのですか?

大島:まさにその4月28日から見ていましたよ。これは何なんだ、と驚きましたね。当然、ヤマハ社内でも話題になっていて……。当時、私はY2プロジェクトという部署に異動してきたばかりのころで、クラウドビジネスについて考えていたときでした。NetVOCALOIDなどが構想されていましたが、その矢先に、PROLOGUEを見て、VOCALOID技術は奥深いなと思うと同時に、何かできるのでは……と直感しました。そして翌日には、「なんだ、これは後藤さんたちの仕業だったのか!」と。以前から後藤さんとは学会でお会いしていて、よく知っていましたから。剣持とも、これは音楽情報科学研究会の学会発表に行くしかないよね、と翌月に神戸で行なわれた学会に参加したのです。

――なるほど、学会発表前から、ヤマハとしては動きだしていたわけですね。素早い動きではあったけれど、実際の発売までには、ずいぶん時間がかかりました。今回の発売までの過程で「Netぼかりす」といったものも、出たり消えたりしていましたが…。

大島:本当に長らくお待たせして申し訳ありませんでした。さまざまな複合的事情から当初予定より、ずいぶん遅くなってしまいました。経緯を簡単にお話します。

|

| Netぼかりすα版 |

まず、2008年5月の学会で「産総研とヤマハでいっしょにやりましょう!」と後藤さんと意気投合。11月から正式に共同研究としてスタート。Y2プロジェクトとしてはクラウド型のビジネスを行なうという課題があったので、「ぼかりす」をクラウド型のシステムとして開発を進めていったのです。その結果、翌年3月ごろにはある程度試すことができるものができました。HTMLベースのアプリであり、Windowsのみで動作するというシステムではありましたが、PCにインストールされているVOCALOIDのシンガーを選ぶことができるようになっていて、人が歌った歌と歌詞を放り込むと結果としてVSQファイルが返ってくるものができあがったのです。

――なるほど、それが2009年4月27日にヤマハからプレスリリースがあった「歌声合成パラメータ推定技術VocaListenerの実用化にヤマハと産総研が連携~VOCALOIDで手軽に高品質な歌声を!」という発表ですね。

大島:実は、そのプレスリリース前に一部のボカロPさんにコンタクトをとり、試してもらいはじめていたのです。翌日、つまりPROLOGUEからちょうど1年の4月28日には投稿解禁としたため、一気に20曲くらいの、「ぼかりす」調教による楽曲が公開されました。

ただ、こうしていろいろな人に使ってもらうと問題も見えてきました。まずは、人間の歌ったオーディオデータと歌詞を入力したら、完全オートマティックで結果を生成するというのは難しいことが見えてきました。端的にいえばVOCALOID EditorはMIDIエディタであるのに対し、「ぼかりす」はオーディオエディタです。これを完全に統合するのはかなり無理があったのです。そのときのα版「Netぼかりす」では一発変換としていたので、できあがったデータは、すべてVOCALOID Editor上でエディットしなくてはなりませんでした。しかし生成されたVSQファイルは、オーディオデータのように膨大で、また緻密な合成パラメータで構成されています。これをMIDIエディタであるVOCALOID Editorで修正するのには限度があります。

試用いただいたみなさんからも、「手で修正するのは不可能だけど何とかならないか」といった要望が寄せられました。結果的には、まだすぐにビジネスにできる段階ではないと、システムの作り直しを行ないました。当初、HTMLベースで作っていたアプリをFLASHベースにするとともに、ある程度の編集もできるようにしました。

|  |

| Netぼかりすα版の調教による公開楽曲 | FLASHベースのアプリで、編集も行なえるようになったNetぼかりすβ版 |

また、クラウド型のビジネスを展開する上での協力企業も現れました。それがボーカロイドストアを運営している、ビープラッツです。それなりにものができあがり、2010年秋の「デジタルコンテンツEXPO 2010」で発表してしまったのですが、これがまた早すぎました。やはり商品レベルの視点で仕様や性能をみたときに、まだまだ課題があったのです。クラウド型にするということのために、産総研が作った「ぼかりす」と比較してかなり機能を絞り込んでしまっており、結果的にはユーザーの期待するものになっていない、と。ずいぶんと回り道をしましたが、その結果、クラウドでのサービスを一旦保留し、ローカルで動かすものにしよう、ということになったのです。

さらに、VOCALOID3の登場が控えていたので、VOCALOID3 Job Pluginとして動作するものにしようということになっていきました。その後、UIを試行錯誤していろいろと使い勝手を追求していった結果、今のタイミングとなってしまったのです。

|  |

| 2010年秋の「デジタルコンテンツEXPO 2010」で発表されたNET VOCALIS | 製品版「ぼかりす」はVOCALOID3のJob Pluginとして組み込んで使う |

――待ちに待ったという感じではありますが、まずは無事発売されるとのことなので、安心しましたし、とっても楽しみです。今回の製品、ターゲットユーザーはどの辺の人たちになるのですか?

大島:当初は初心者ユーザーがVOCALOIDのデータ入力をしやすくなるためのツールという位置づけも考えていましたが、長期間試行錯誤する中で、その考え方は諦めました。やはりDAWと連携して使うことが前提になるなど、それなりのノウハウが必要になるため、VOCALOIDおよびDTMにおける中級・上級ユーザー向けの製品と考えています。

とはいえオプション設定によっては音符の自動配置ツールとしても活用できるので、決して初心者には用をなさないというものではありません。

|  |  |

| まずボーカルレコーディングしたオーディオを取り込むと自動的にピッチや音量が解析される | 歌詞を入力すると、それを元にさらに解析が進む | 「ぼかりす」の解析後にデータをVOCALOID3 Editorに戻すとダイナミクスやピッチのパラメータが人の歌い方を真似るように細かく調整されている |

■ 次期バージョン「ぼかりす2」では声色の変化にも対応

――ところで、ひとつ気になるのは、産総研では、「ぼかりす2」なる次のバージョンが発表されていることです。2010年の学会、「歌声情報処理最前線!」に参加させていただいたときに、「ユーザ歌唱の音高と音量だけでなく声色変化も真似る歌声合成システムの提案」として中野さん、後藤さんの連名で発表されていました。こうした機能は、今回の製品である「ぼかりす」には反映されないのですか?

中野:いろいろと誤解もありそうですが、今回発売される「ぼかりす」で反映されるものではありません。「ぼかりす」は声の高さと大きさの2つでしたが、「ぼかりす2」ではこれに加えて声色の変化も扱えるようにしました。ただ、それはVOCALOIDのパラメータでは表現できないのです。

「ぼかりす2」開発のキッカケになったのは、初音ミクAppendの発売です。初音ミクAppendでは同じ初音ミクながら、SWEET、SOFT、VIVID、DARK、LIGHT、SOLIDと6種類の声質があり、曲の雰囲気などによって好きな歌声を選べるようになりました。しかし、通常ユーザーはいずれかの歌声を選ぶという選択肢しかありません。そこで「ぼかりす2」では声質まで真似させようと、各歌声の中間的な歌声も外部で合成できるようにしたものなのです。単に切り替えるのでは表現力にも限界がありますから、連続的に自在に変化できるようにしたのです。

|

| 「ぼかりす2」の概念図。「ぼかりす」は「ぼかりす2」の部品の一部になっており、非常に複雑なシステムである |

後藤:だから、「ぼかりす2」は「ぼかりす」とは異なり、VOCALOIDで完結するものではありません。結果をVSQ、VSQXファイルとして扱えるわけではなく、外部の我々のシステム上で信号処理をし、合成するものとなっています。そのため「ぼかりす2」は「ぼかりす」と比較すると、計算量も膨大で大規模なシステムとなっていますし、内容的にもバージョンアップ版というよりは、別のソフトといってもいいものなのです。

大島:ヤマハとしても、これは別のソフトであると捉えており、今回リリースする製品も最初のバージョンである「ぼかりす」がベースになっています。

――なるほど、よく分かりました。最後に、「ぼかりす」がようやく発売に至ったことについて、みなさんの感想をお聞かせください。

中野:自分の開発した技術が製品となるのは、今回が初めてです。そのため、とても嬉しいですし、実際にユーザーのみなさんが使った結果、どんな作品が登場してくるのかも、とても楽しみです。

後藤:1日も早く発売されてほしいとずっと願っていたので、今回の発売、心から嬉しいです。歌声合成では、必ずしも「ぼかりす」のような自然性の追求だけでなく、歌声合成ならではの従来にない表現を切り拓くことも大切です。とはいえ、人間に近い自然な歌唱表現を合成したいときには可能にする選択肢もやはり不可欠です。我々の研究成果が、そうした選択肢として皆さまに受け入れられ、我々も大好きな歌声合成文化の発展に貢献できればと願っています。

大島:本当にお待たせしてしまいましたが、「ぼかりす」はVOCALOIDの世界を大きく広げる可能性を持ったツールです。ぜひ多くの方々に使っていただき、新しい作品の制作に活用していただけたらと思っています。

――ありがとうございました。