第493回:「歌声情報処理最前線!! 」でのボカロ最先端技術

~“島唄”風、ロボットの表情と連動、motsuのラップ合成など ~

2月3日、情報処理学会の音楽情報処理研究会と音声言語情報処理研究会の共同でシンポジウム、「歌声情報処理最前線!!」が浜松で行なわれた。これは2010年7月に筑波山で行なわれたものに続く第2回目で、今回も歌声に関する研究内容ばかり、計11の発表が行なわれた。

|  |

やはり学会発表だけに、数式いっぱいの難しい内容もあったが、デモを交えた楽しい発表もいっぱいだった。歌声に関連する研究だけにVOCALOIDやUTAUなどの歌声合成システムに関連するものが多かったのだが、中でも分かりやすい発表についてピックアップして紹介してみたい。

今回の「歌声情報処理最前線!!」、正確にいうと2月3日、4日の両日に行なわれた音楽情報処理研究会(SIGMUS/音情研)「第94回研究発表会」の初日のスペシャルセッションという位置づけ。前回の「歌声情報処理最前線!」の延長線上にあるものも多かったのだが、その内容はニコニコ生放送、Ustreamでも生中継され、デモ演奏なども含めて公開されたため、さまざまな人が見ていたようだ。

すべてを紹介していくと、かなりの量になってしまうため、デモが分かりやすく、内容的にも面白く感じられた以下の4つを見ていくことにしよう。なお、11あった発表内容は、本稿の最後に記載している。

(3) 奄美大島民謡風歌声合成システム:グインレゾネータ

(6) [依頼講演] VocaWatcher: 人間の歌唱時の表情を真似るヒューマノイドロボットの顔動作生成システム

(7) ラップスタイル歌声合成の検討

(10) v.Connect:ユーザが声色操作を指定できる歌声合成器

■ 奄美大島民謡風の“島唄”にする歌声合成

|

| 関西学院大学の村主大輔氏 |

「奄美大島民謡風歌声合成システム:グインレゾネータ」は関西学院大学のチームが中心となり、「自分の声をプロのような歌唱にする歌声情報処理技術の開発」を行なおうということで取り組んだもの。発表者は同大学の村主大輔氏。もちろん「プロのような歌唱」と一言でいっても、いろいろあるが、ここではその歌い方に独特な特徴をもった奄美大島民謡の歌手のような歌い方をするプロを目指している。

奄美大島民謡といってもピンと来ない人もいるかもしれないが、いわゆる「島唄」であり、奄美大島出身の歌手としては元ちとせさん、中孝介さんなどがいる。彼らの歌は独特な歌唱スタイルであり、これこそが奄美大島民謡の歌い回しなのだ。これを真似た節回しをする歌声合成システムに取り組んだというわけだ。

奄美大島民謡は元ちとせさんなどの歌を聴いてすぐに独特であることは感じるが、どこが普通の歌と違うのか。それは裏声を多用するとともに、ここに、こぶしを効かせた歌唱法となっている。普通、裏声というと、音高が限界を超えたところで使うものだが、奄美大島での歌唱法では、地声で出せる低い音でも裏声を使っている。これを「グイン」と呼ぶそうだが、普通の歌をグイン化することで、奄美大島民謡風になるのだ。ただ、問題はグインの音響特性はどのようにすれば表現できるのか、そして楽曲のどの位置でグインを付加すればいいのか、という点だ。

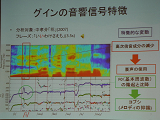

そこで、このチームではまず実際の曲の分析を行ない、グインの音響信号特徴を調べている。具体的には中孝介さんの「花」という曲の一節を周波数分析すると、グインが使われているところで、高次倍数成分が減っているのが分かる。またこの部分のピッチに抑揚があり、ここにコブシが使われているのも見て取れる。逆に考えると、フィルターを使って裏声化をするとともに独特なピッチ変化をつけることで、グインを実現できるというわけだ。

さらに楽曲中でグインの表現されやすい位置が存在することも統計から導き出すことに成功。明確なルールがあるわけではなかったようだが、ある程度のルールが見えてきたので、それを適用した結果、さまざまな歌を島唄化できたというわけだ。もちろん、これは大学での研究成果というレベルですぐに商品化するといったものではないが、コンピュータ処理によって民謡風になるという研究は非常に斬新なものに感じられた。

|  |  |

| 奄美大島民謡の歌手のような歌い方を追求 | グインが使われているところで、高次倍数成分が減っている | 楽曲中に、グインの表現されやすい位置が存在している |

| 【音声サンプル】 | |

| グインを付ける前 (YouTubeで再生) | グインを付けた後 (YouTubeで再生) |

| 会場で流されたサンプル曲(なごり雪) | |

■ 歌い手の顔の動きをロボットの「未夢」で再現

|

| 産業技術総研究所の中野倫靖氏 |

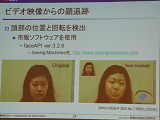

次に紹介する「VocaWatcher: 人間の歌唱時の表情を真似るヒューマノイドロボットの顔動作生成システム」は、歌声そのものではなく、歌をうたうロボットの表情を作るという、今回の発表の中ではちょっと異色なもの。発表を行なったのは産業技術総研究所の中野倫靖氏。中野氏は、間もなくヤマハから発売される予定の「VocaListener(ぼかりす)」を開発した中心的メンバーでもある。

今回発表の「VocaWatcher(ぼかうお)」はビデオカメラで撮影した顔表情を元に、これを真似てロボットの顔動作を生成するという技術。そしてこれを、「ぼかりす」といっしょに使うことで、非常に面白い効果が得られるようになっているのだ。まずは、このビデオをご覧いただきたい。左が実際に歌った人、右が産総研のヒューマノイドロボット、HRP-4C「未夢(ミーム)」の顔の動きであり、このビデオでの歌声はVOCALOID2の初音ミクによるものだ。

歌声が非常にリアルになっているのは、人間の歌声を元にこれを細かく分析した結果をVOCALOID用のパラメータとして吐き出した結果を利用しているから、顔の動きがよく似ているのは、歌唱者の顔の動きを分析し、頭部の位置、頭部の回転、視線、まばたき、口の開きなどを抽出。それを未夢の動きに反映させているからだ。

|  |

| 頭部の位置、頭部の回転を検出 | 視線、まばたきに関する動作 |

このデモは「CEATEC 2010」などでも行なわれていたので、筆者も以前に実物を見たことがあったが、このように撮影されたビデオを見ると、パッと見ではロボットとは思えないほどだ。ただ、あまりにもよくできているだけに、ちょっと不気味に感じる人もいそうだ。それを「不気味の谷」現象というのだそうだ。人間から遠くデフォルメされていると親近感を感じやすくても、人間に近づく過程で違和感を感じることを、そう呼んでいる。中野氏は技術進化の過程でそうしたことは起こるので、「不気味の谷」に差しかかることを恐れずに研究を進めていくという。

■ ヤマハらがmotsuの協力で「ラップスタイル」の合成

|

| ヤマハの才野慶二郎氏(左)と名古屋工業大学の大浦圭一郎氏(右) |

「ラップスタイル歌声合成の検討」は名古屋工業大学の国際音声技術研究所とヤマハのボーカロイドの開発チームによる共同研究による発表と非常にユニークな組み合わせとなっていた。壇上に立ったのは、ヤマハの才野慶二郎氏と名古屋工業大学の大浦圭一郎氏。

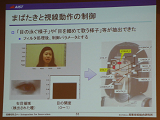

ご存知のとおり、ラップは歌としゃべりの間にある形態のもので、単に文字だけでは表現できないし、従来の楽譜で表現できるものでもない。また、一言でラップといっても、人によってその表現の仕方に違いがあるようだが、ここでは特定の歌い手のスタイルを再現することにトライしよう、ということで、エイベックス・マネジメント所属のアーティストであるmotsu氏(M.O.V.E)の協力も得て研究が進められた。

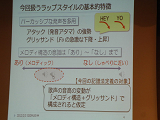

motsu氏のラップスタイルの基本的な特徴としては、発音の頭部分が強くアタック感のあるものとなっているほか「HEY」、「YO」といったピッチが急激に下がったり、上がったりするグリッサンドの効いた発音になっていることが挙げられる。一方、曲によって音程があるメロディックなものと、しゃべりに近いものまで幅があることも分かった。

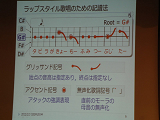

音程と実際のピッチ変化を図に表してみると、グリッサンド効果などにより、なかなかユニークな形になっていることが分かる。そこで、まずはこれを表現するためにラップスタイル歌唱のための記譜法を編み出している。これを見ると分かるとおり、音程と発音位置、歌詞を指定するとともに、上がるのか下がるのかのグリッサンド記号を記述できるようにしている。

|  |  |

| motsu氏のラップスタイルの特徴 | 音程と実際のピッチ変化 | ラップスタイル歌唱のための記譜法 |

|

| Sinsy |

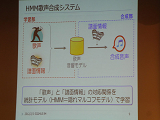

ところでヤマハのVOCALOIDは「素片接合型合成」という方式で歌声合成を行なっている。簡単にいえば母音や子音などをバラバラに録音したデータをデータベースライブラリとして持っておき、歌詞や音程によってそれを組み合わせて合成するという方式だ。それに対し、名古屋工業大学ではHMM(隠れマルコフモデル)音声合成という方式を採用したSinsyというシステムをすでに発表し、誰でもWeb上で利用可能なサービスとして公開している。

これは「HMMテキスト音声合成」技術をベースに歌声用に応用したもので、VOCALOIDのように波形を保持するシステムとは大きく異なる。数多くの歌唱データを元に音の変化などから抽出したメタデータをデータベース化し、それから推定によってオリジナルと似た歌声を実現するという方式。素片接合型合成と比較して圧倒的に小さなメモリ容量で動作するのが特徴だ。

|

| 歌声と譜面情報を元に歌声音響モデルのデータベースを構築、そこに譜面情報を与えるという方法 |

もともとラップを想定して作られたわけではないVOCALOIDの場合、ラップを実現するのは難しい。一方、既存のデータから学習して歌わせることが可能なHMMであれば、ラップでも実現性は高いことから、まずはSinsyを使っての再現をおこなっている。ここでは歌声と譜面情報を元に歌声音響モデルのデータベースを構築し、そこに譜面情報を与えることでラップの音声合成を実現するという流れである。実際このSinsyを使ったラップ合成システムを使い、ヤマハの才野氏が作ったオリジナル楽曲を歌わせたデモが披露された。これを聴いてみると、motsu氏の歌い方にとてもよく似たラップの歌声が実現できているのが分かる。

次に、このSinsyで作られたデータから音高、音量、音素長といったVOCALOID用として使えるパラメータを抽出。これをVOCALOID3 VY1V3に適用してみたところ、結構それっぽく歌ってくれるのだ。

最後にはSinsyによるラップの歌声と、VOCALOID3によるラップの歌声の双方をミックスしたデモが披露され、会場からも賞賛を浴びた。

| 【音声サンプル】 | |

| sinsy.mp3(313KB) | vocaloid_sinsy.mp3(587KB) |

| Sinsyを使ったラップ再現 | Sinsyを使った合成ラップに、オリジナル楽曲を歌わせたもの |

■ 2種類の歌声ライブラリを同時利用できる技術

|

| 修羅場Pこと小川真氏 |

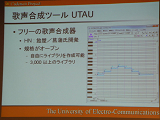

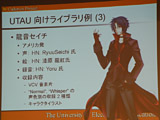

最後に紹介するのは、修羅場Pとして楽曲制作に取り組んでいることでも知られる小川真氏を中心とした電気通信大学のチームによる「v.Connect:ユーザが声色操作を指定できる歌声合成器」について。VOCALOIDの世界では初音ミクAppendや「Power」、「Whisper」、「Adult」、「Sweet」と展開するMegpoidのように、1人の声でありながら表情の異なるライブラリが複数出ていて、どのライブラリを使うかによって異なる雰囲気の歌声を作り出せるようになっている。

ただ、基本的にライブラリを切り替えて使う形であるため、曲中で切り替えると違和感が出てしまうこともあるし、PowerとWhisperの間の音といったものを作り出すことができない。そこで、その切り替えをモーフィング技術によって滑らかに行ない、中間的な歌声も出せるようにしようというのが、v.Connectでの取り組みだ。

|  |

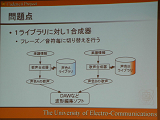

| 飴屋/菖蒲氏開発のUTAUを利用 | 1ライブラリに対し1合成器である時の問題 |

ただVOCALOIDの場合、ヤマハがエンジンからユーザーインターフェイスまですべてを行なっているため、これに手を加えるというのはなかなか困難。そこで、フリーウェアであり、シーケンサ部やエンジン部などの組み換えも可能な歌声合成ソフト、飴屋/菖蒲氏開発のUTAUを利用して行なったプロジェクトとなっている。

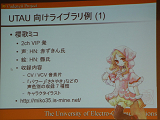

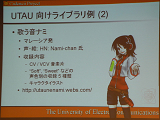

このUTAU用には、一般ユーザーが作った歌声ライブラリが約3,000近くあるといわれ、その中にはSoft、Sweetなど複数の声色を持ったライブラリもいろいろ存在している。通常はこの複数のライブラリで歌わせたものをDAWなどでミックスして使っているが、その場合、前述のような問題が起こってしまう。そこで、ここでは2つのライブラリを同時に扱えるようにし、2つの間をパラメータの値によって自由にモーフィングできるようにしているのだ。

|  |  |

実際の方法論は複雑で、筆者にもよく理解できなかったので省略するが、歌声合成エンジンには前の発表で登場した立命館大学の森勢将雅氏らが開発したWORLDを採用。またシーケンサにはkbinani氏開発のCadenciiを使用する形でデモを行なっていた。また音源には「波音リツ」を採用し、システム一式とセットにした「波音リツコネクト」というパッケージを無料配布しているので、興味のある方はダウンロードして使ってみると面白そうだ。

また、この波音リツコネクトを利用し、実際に小川氏が修羅場Pとして作った作品もニコニコ動画にアップされているので、見てみてはいかがだろうか?

|  |  |

| 実際の手法 | シーケンサにはCadenciiを使用してデモ | 波音リツコネクト |

歌声情報処理は、日本が先端を行く技術分野であり、このような学会で研究発表が行なわれると同時に、VOCALOIDのような製品、サービスどんどんと出てきている非常に活気ある世界だ。素人目に見ても、前回より今回のほうがさらに技術が進んできていることが実感できたが、まだまだ新しく面白い技術が登場してきそうなので、今後もウォッチしていきたいと思っている。

- 【歌声情報処理最前線!! の発表内容】(敬称略)

◇スペシャルセッション「歌声情報処理最前線!!」第1部

座長:中野 倫靖(産総研)

(1) [依頼講演] 自動学習により人間のように歌う音声合成システム Sinsy

・徳田 恵一、大浦 圭一郎(名工大)

(2) アマチュア歌唱エンタテインメントのための熱唱度評価システムSEES

・大道 竜之介(東北大)、伊藤 仁(東北工業大)、牧野 正三(東北文化学園大)、伊藤 彰則(東北大)

(3) 奄美大島民謡風歌声合成システム:グインレゾネータ

・村主 大輔、馬場 隆(関西学院大)、森勢 将雅(立命館大)、片寄 晴弘(関西学院大)

◇スペシャルセッション「歌声情報処理最前線!!」第2部

座長:伊藤 彰則(東北大)

(4) [依頼講演] 歌声合成ソフトウェアVOCALOID3とVOCALOID Job Plugin

・剣持 秀紀(ヤマハ)

(5) [依頼講演] 日刊VOCALOIDランキング: ランキング動画全自動生成システムとその運用

・rankingloid(ニコニコランキング動画制作組合)

(6) [依頼講演] VocaWatcher: 人間の歌唱時の表情を真似るヒューマノイドロボットの顔動作生成システム

・中野 倫靖、後藤 真孝、梶田 秀司、松坂 要佐、中岡 慎一郎、横井 一仁(産総研)

(7) ラップスタイル歌声合成の検討

・才野 慶二郎(ヤマハ)、大浦 圭一郎(名工大)、橘 誠、剣持 秀紀(ヤマハ)、徳田 恵一(名工大)

◇スペシャルセッション「歌声情報処理最前線!!」第3部

(依頼講演25分x1 + 一般講演20分x3)

座長:後藤 真孝(産総研)

(8) [依頼講演] 歌声のテクスチャに信号処理はどう迫るか

・河原 英紀(和歌山大)

(9) 協調的創造活動支援を目的とした歌声合成基盤技術の研究開発

・森勢 将雅(立命館大)、河原 英紀(和歌山大)、小川 真(電通大)

(10) v.Connect:ユーザが声色操作を指定できる歌声合成器

・小川 真、矢崎 俊志、阿部 公輝(電通大)

(11) 歌唱における意図表現を考慮した歌声F0生成過程とその統計的モデリング

・大石 康智(NTT)、亀岡 弘和(東大/NTT)、持橋 大地(統数研)、柏野 邦夫(NTT)