小寺信良の週刊 Electric Zooma!

第1196回

「Creative for All」をAIで実現するAdobeの方法論

2025年11月5日 08:00

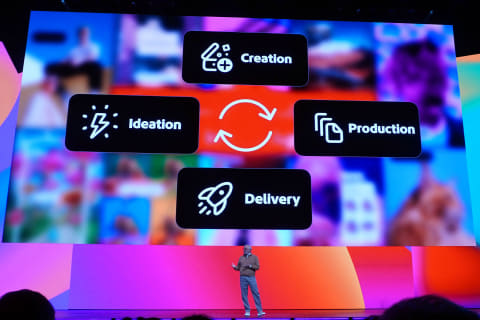

クリエイティブの中心にAIを据えるとどうなるのか

10月28日から30日の3日間、米国ロサンゼルスにてAdobe MAX 2025が開催された。Adobe MAXは米国Adobeの年次イベントであり、ここで発表された技術をベースに、各国でローカルイベントが開催されるという事になる。要するにここから1年間のデジタルクリエイティブがどうなるのかを占う上で、重要なイベントだ。筆者も現地に赴き、このイベントに参加する機会を得た。

今年のAdobe MAXは、初日のキーノートだけでも3時間に及ぶ長丁場であり、非常に多くの技術が発表された。加えて現在開発中の技術をお披露目する「Sneaks」でも、非常に完成度の高い技術が公開された。しかしそれらを技術の羅列として見ているだけでは全体像はつかめない。

今回はAdobe MAX 2025で発表された技術を俯瞰的に見ながら、プロのクリエイターはもちろん、ノンプロのクリエイターや、クリエイティブに関わるクリエイター以外の人たちにとってどのような影響があるのかを考察してみたい。

AIによるプリプロダクション

生成AIが話題である。SNSには生成AIを使った画像や動画が溢れ、何が本物なのか見分けがつかない状態となっている。しかしこれは、生成AIがアマチュアのおもちゃになりうるということを示したに過ぎず、アマチュアがプロクリエイターになれるという意味ではない。

一方商業コンテンツに関わるプロクリエイターにとっては、生成AIをどのように使っていくかは大きな課題となっている。安易に使えば、盗作や剽窃、著作権違反になりかねず、慎重を要する。そんな中で、学習ソースがすべてライセンスされた素材を使って作られたAdobe Fireflyは安心して使えますよ、というところが、これまでのAdobeのメッセージであった。

だが今回のイベントではさらに「その先」のクリエイティブが示されたように思う。それは、本番のクリエイティブを行なう前段階で仮に作成する「プリプロダクション」に生成AIを使っていくという方向性だ。プリプロダクションはあくまでも試作であり、これが直接表に出ることはない。したがって間違って何かに似ていても、公表しないものなので問題にならない。

一旦ここで、Adobe Fireflyの拡張を整理しておく。ここからご紹介する機能は、Fireflyがベースになるからだ。これまでも他社の生成AIを組み込むというアナウンスはされていたところだが、今後は3タイプのモデルが利用できるようになる。

1つ目は従来同様、Adobeオリジナルの生成AIである「Adobe Models」だ。これは静止画や動画のイメージモデルだけでなく、ベクターで生成できるベクターモデルや、デザイン自体を生成できるデザインモデル、音楽やSEを生成できる音系のモデルなどを含む。特にベクターモデルや3Dモデルは、他社のAIではあまりやっていない分野で、Adobe Modelの強みである。

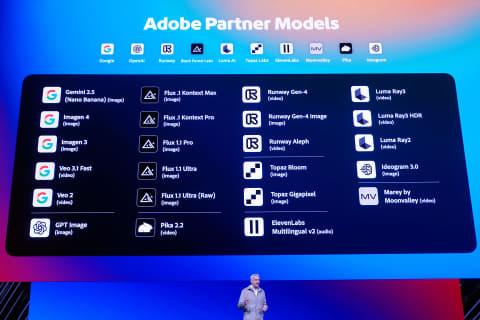

2つ目は、他社のイメージモデルを大量にサポート・統合した「Partner Models」だ。Google、OpenAI、Black Forest Labsなどが提供するモデルが、Adobe Modelと切り替える格好で選択できるようになる。

生成AIには作業内容による得意不得意があり、また出力結果も異なるため、多彩な表現を得るためには他社製AIを使うことも必要である。加えて、これらの生成AIを使う場合にも、いちいち他社と個別に契約して支払いを行なう必要はない。他社モデルへはAdobeの生成クレジットから支払われるため、まさに一元的な管理が可能になる。

3つ目は、特定のイメージやデザインを学習する「Custom Models」だ。例えばアーティストの過去の作品を学習させることで、いわゆる作風を学習させることができる。あるいは企業のコーポレートイメージを学習させることで、極端にイメージから離れることのない生成結果が得られる。

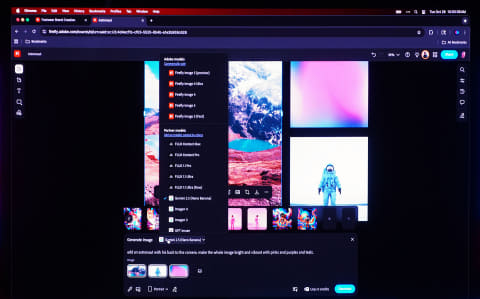

これを踏まえた上でご紹介するのが、「Firefly Boards」だ。これはいわゆるアイデア出し用のツールである。ベースとなる素材を登録し、それらを組み合わせるとどうなるかといった実験が、生成AIを使ってシミュレーションできる。また同じ条件で別の生成AIを使ったバリエーションもいっぺんに作成することができる。

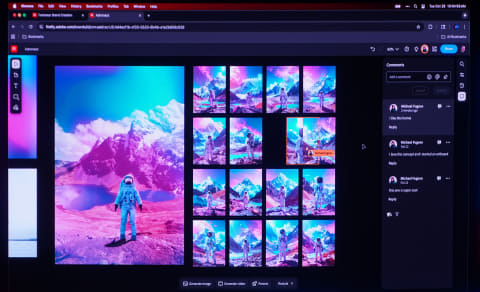

また他のデザイナーやクリエイターを招いて、コラボレーションすることもできる。単に意見やアイデアをもらうだけでなく、実際に絵をいじってもらうこともできる。

例えば大掛かりな新製品キャンペーンなどのプロジェクトでは、商品パッケージからポスターやテレビCM、WEB広告など、様々な露出イメージを統一する必要がある。それを1人のデザイナーがすべて面倒を見ることはできないので、どうしてもデザインチームとして動くことになる。こうした場合に、あらゆるイメージのクリエイティブが1つのボード上にあれば、チーフデザイナーがすべてのイメージに対して目を通すことができる。

一方で、こうしたプリプロダクション中には、あらゆる可能性を試してみるために生成AIがフル回転することになるので、大量の生成クレジットが必要になる。すでに予算がついて制作に入っているなら問題ないが、コンペなどお金が入るかどうかわからない作業に大量の生成クレジットを投入するのは、フリーランスや小規模なデザイン事務所には難しく、ある程度の規模の企業ということになるだろう。

ノンクリエイターへの支援

一方で、クリエイターとはいえない人たちにとって、デザインワークは敷居の高いものである。例えば飲食店の前に張り出された新メニューのお知らせみたいなものにWord Artの3D文字などが使われていると、「ああ……ね?」という嘆息する。

こうしたノンクリエイターな人たちにテンプレートを使ってパパッといいものが作れるというツールが、Adobe Expressの立ち位置である。

そのAdobe Expressに、AIエージェントが組み込まれる。これまでは、プロンプトで指定することで直接画像生成していたものが、AIエージェントと相談しながらイメージ生成するという流れになる。

またAdobe Expressには大量のテンプレートが用意されているが、そのテンプレートを自分でいじってカスタマイズするのが苦手という人も多い。この場合は、この部分をこうして、とAIにテキストで指示することで、必要な修正ができる。例えば背景を赤系にしてとか、文字を目立たせて、といった抽象的な指示でも、AIが理解してくれる。

Adobe ExpressとAIエージェントの組み合わせは、まだ自分がどんなものが作りたいのかが見えている人が使うものだ。それよりもさらに前の段階、アイデア出しからやりたいという人は、いきなりAdobe Expressに手を付けても先が見えない。

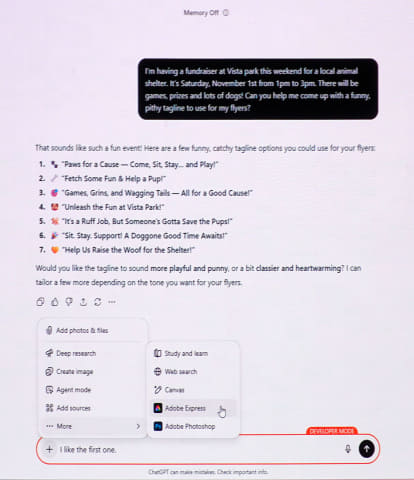

こうしたブレインストーミングを行なう相手として、OpenAIのChatGPTはすでに多くの人に使われている。ただそこでアイデアを練っても、所詮はテキストになっているだけで、それをAdobe Express上にどうやって持っていくのか、という問題があった。

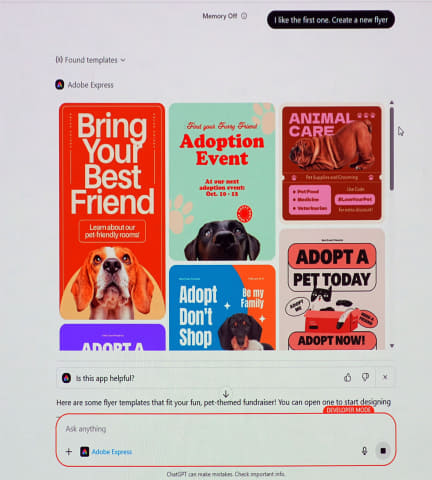

そこでアプローチとして、ChatGPTにAdobe Expressを操作させるという方法論を開発した。実際にはChatGPTからAdobe ExpressのAPIを操作するという形で実現しており、他にもPhotoShopのAPIも操作できる。

ブレストして提案されたアイデアをもとにChatGPTがフィットするデザインテンプレートを検索し、使用者に提案する。それを選んでカスタマイズしていくわけだ。色を変えたりアニメーションさせたりといった指示もチャットで行なえる。

ここでChatGPTを使うのは、Fireflyは画像処理系のAIなので、テキストチャットでアイデア出しのようなことが苦手だからだ。いわゆるAIアシスタントとしてのあり方が違うということである。

だがそうしたアイデア出しのAIも、Adobeは自前で開発を進めている。キーノート後半に紹介された「Project Moonlight」がそれだ。Adobeで「Projectなんとか」というのは開発中の技術で、最終的にはそれがどのような形でどのアプリやサービスに組み込まれるのかはまだ決まっていないものを指す。ただこのプロジェクトに関しては、Fireflyに組み込まれることになっている。

このProject Moonlightは、上記ChatGPT+Adobe Expressと似たような動きではあるが、もう少しプロクリエイター向けのツールとして展開される。

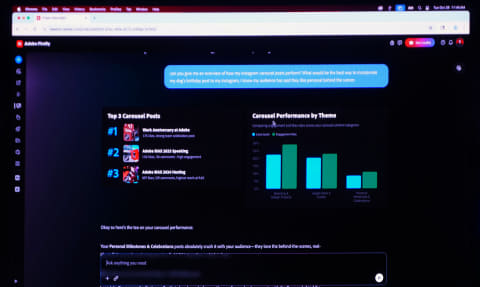

コンテンツの企画のブレスト段階では、Lightroomなど同社のアプリ内のコンテンツを参照することができ、そこからアイデアを練っていく。画像解析により、細かい情報をテキスト入力しなくても、ある程度の情報を取得することができる。

またInstagramと連携してのパフォーマンス分析、テーマ別の傾向、最適戦略などを提示してくれる。さらにはFirefly Boardsでの検討結果なども読み取ることができ、複数のサンプルイメージを提示してくれる。それらはPhotoshopやExpressへ受け渡され、仕上げまで持っていくことができる。

生成AIの「軸」の発生

これまで生成AIは、新たに画像を作り出すという方向性が強調されていた。PhotoshopではAIを使って特定のオブジェクトを消すといった作業が可能だったが、これも「作り出す」の一種である。削除したオブジェクトの背景がどうだったのかを生成していたわけだ。

今回のAdobe MAXでは、こうしたAIによる「生成軸」の他に、新たに「加工軸」というものが生まれたのではないかと思う。これは、オリジナルの画像の修正や補正をメインとして、新しい要素を書き込むのではなく、従来人間が手作業でやっていたクリエイティブ~フィニッシング作業を代行するという考え方だ。

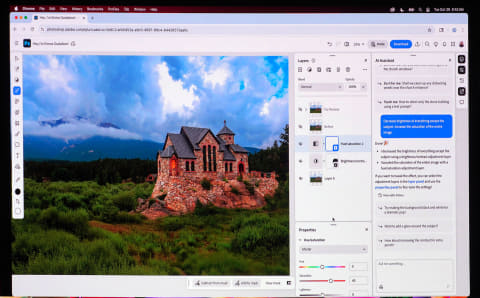

筆者が考える加工軸の例としては、Photoshopに搭載されるAIエージェントの使い方にある。エージェントの搭載はAdobe Expressと同様のように思えるが、画像を拡大した際の荒れを低減する高解像度化や、2つの画像をレイヤー合成した際の馴染みをよくする合成調整といった機能は、Adobe Expressのユーザーにはあまり必要のない機能だ。

例えば「背景だけコントラストを上げて」、みたいな指示を与えたとする。人間がこれをやろうとすれば、手前のオブジェクトをマスクで切って別レイヤーに切り分けたのち、残った背景を調整するという手順が必要だ。これをAIにコマンドを投げることで、オブジェクト選択からレイヤー分け、背景のコントラスト調整までを自動で行なってくれる。これは、従来の画像生成という考え方では収まらない動作である。

あるいはLightroomで、写真上に現れたセンサーやレンズ上のホコリの影を一括消去するといった機能も、いわゆる背景やオブジェクトの削除といった生成軸とは、違う考え方で捉えるべきである。つまり新たな要素を加えるのではなく、元々オリジナルはこうあるべきだったという、完成の方向性に整えるためにAIを使う。

AIの挙動から見ればやっていることは大して変わらないかもしれないが、ユーザーのマインドが大きく異なるという点は、AIによる補正や修正が社会問題となっていく中で、意味合いは小さくない。元画像を食わせて似たような絵を生成させた画像と、ホコリを取っただけの画像を“どちらも生成AIでしょ”では片付けられないし、そこは区別されるべきだ。

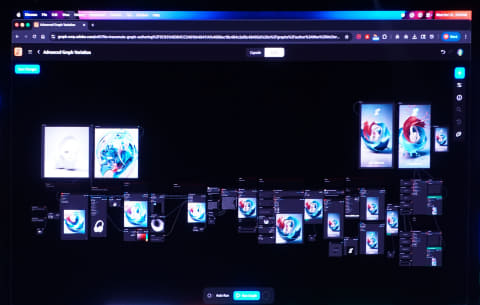

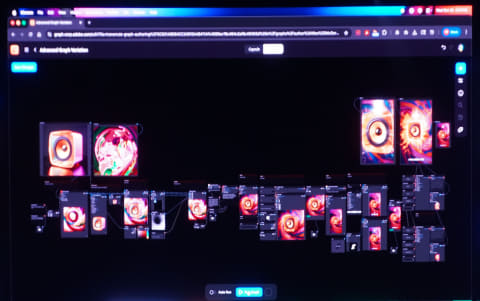

もう一つ、AIを使った加工軸に該当するものとして、「Project Graph」がある。これはクリエイターが画像を加工していくプロセスを1つのワークフローと捉え、バッチ化できるというものだ。

例えばある画像に対して、Photoshopのプラグインや加工機能を呼び出し、それをカプセルという形のパッケージ化を行なう。画像の加工は、パラメータをいじるためのUIとも接続できる。このカプセルを複数個パイプライン接続することで複雑なワークフローを構築できる。Davinci ResolveのFusionページみたいなものを想像すればそう外れてはいないだろう。

これまで感性の赴くままに突っ走っちゃった画像加工は、じゃあ別の絵でも同じことをやって、と言われてもなかなか再現できなかった。このProject Graphが優れている点は、複雑な加工プロセスを再現できるということだ。つまり、パイプラインプロセスの入り口にある元素材を変更すれば、あっという間にワークフローを通って加工状態が出力される。パラメータがいじれるUIも付いてくるので、入力画像に応じた調整もできる。

これは、AIがPhotoshopのAPIを呼び出して機能を切り出し、ある種の専用エフェクターとして再プログラミングを行なうというプロセスだと考えられる。今はまだ動画には対応していないように見えたが、これが動画対応した際には大変なことになるだろう。

さらにこうした複雑な加工プロセスが共有できるようになれば、多くの人が自力ではできなかった加工テクニックが手に入る。カメラで言うところの“プロクリエイターが作ったLUTを使えばエモい絵が撮れる”みたいなヤツのポストプロダクション版だ。

これは生成AIで限りなくガチャをひいていくような運任せの制作ではなく、きちんと管理されて結果がコントロールできる制作プロセスだ。プロクリエイターなら、必ず恩恵が得られる技術である。

総論

今回のAdobe MAX 2025は、「Photoshopにこんな機能が追加されました!」「やったー!!」みたいな単純な話では説明できない。AIとクリエイティブの関係は1つではなく、実に多様であることが示された、一種のマイルストーン的な回だったように思う。

テーマとしても、AIの「生成」だけでなく「加工」という軸が生まれたこと、「プロの専門職」と一人でなんでもやってしまう「総合クリエイター」の両方に対してツールを提供する必要が出てきたこと、さらには「非クリエイター」に対しても創造の機会を提供することなど、多様な切り口があり得る。

Adobeとしても、どれをどの順番で発表するべきか相当迷いがあっただろう。AIによって開発がどんどん加速し、多くのプロジェクトが発生していく中で、どれを採用して、どれを採用しないか。クリエイターだけでなく、政府や法に信頼される企業としての責任とスタンスが問われている。