西田宗千佳のRandomTracking

第637回

「生成」の次の段階へ。アドビが進む「AI時代第二章」

2025年10月29日 16:28

今年もアドビの年次イベント「Adobe MAX 2025」の取材に来ている。

昨年はマイアミに会場を移したが、今年はふたたびロサンゼルスに復帰した。現地はトロント・ブルージェイズとロサンゼルス・ドジャーズのワールドシリーズで盛り上がっている最中。まあそれとは別に、今年のAdobe MAXも、多くのクリエイターやインフルエンサーで賑わった。

ここ数年間、Adobe MAXのテーマは「AI」だった。そして、今年もAIが軸であることに変わりはない。

しかし、「新しいモデルでこういう絵が作れます」という話はすでに通過した。

今年のテーマになったのは、クリエイターが生成AIを使う上で必要な多様性と価値をどう担保し、その上で「アドビの強み」をアピールするか、という点にある。

その中では「他社AIモデルの併用」に加え、Googleとの提携が大きな意味を持ってくる。

基調講演の情報から、アドビの戦略を考えてみよう。

アドビが進める「AIファースト戦略」でのワンストップ化

「ダイレクトな操作と生成的なアイデア創出の融合が、私たちが創造する方法を再定義する」

アドビのシャンタヌ・ナラヤンCEOは、基調講演の冒頭でそう表現した。

多くのクリエイターは1ピクセル単位での精密さにこだわり、直接的に操作してコンテンツを作っている。他方で、アイデアを生み出してそれをコンテンツの創出につなげる方法は、生成AIの登場によって多様化した。直接ツールを使って編集する場合もあれば、生成AIに対して詳細をプロンプトなどの形で伝え、効率的に生成する方法もある。

コンテンツのニーズは増大しており、作らねばならないものも増える。

アドビは「なんでも自動でジャンクにコンテンツを増やす」ような話はしていない。

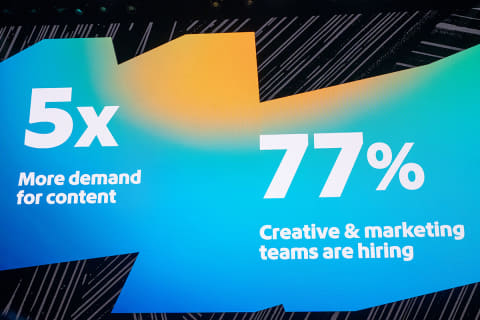

アドビのデジタルメディア事業部門プレジデントであるデビッド・ワドワーニ氏は、「コンテンツの需要は5倍に増え、クリエイティブとマーケティング部門の求人も77%成長した」という。複数のメディアが併存し、個人をターゲットした広告が増える現在、広告を軸にコンテンツの多様化が進む……というのは、アドビにとってはここ数年続くメッセージでもある。

その上でクリエイターのワーク・ライフ・バランスを改善しつつ、同時にクオリティの高い新しいコンテンツを生み出す方法をアピールしている。AIが軸であるのと同様に、その方針自体は昨年から変わっていない。

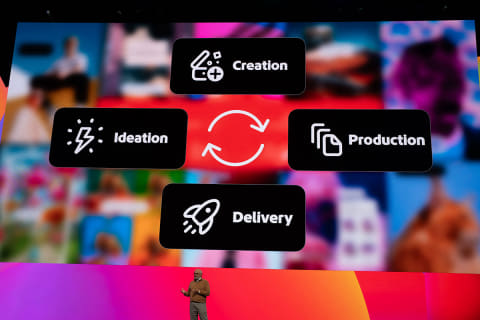

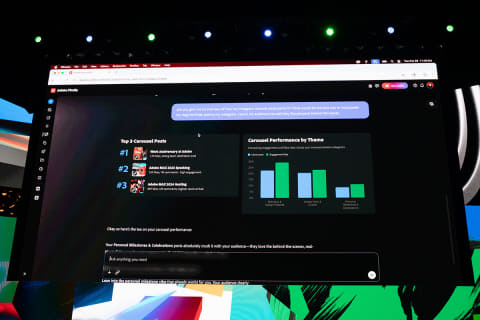

一方、今年強調したのは「制作の全段階をサポートする」ことだった。

作品を作る作業はもちろん、アイデアを練る段階から最終的に「配信」するまで、アドビがワンストップでサービスを提供できる、という点が大きい、という。

自社モデルから「パートナーモデル併用」へ

「ワンストップ」には複数の意味がある。

その1つは全ての工程を……という話だが、クリエイターにとってより重要な点は「様々なAIモデルを使える」ということだろう。

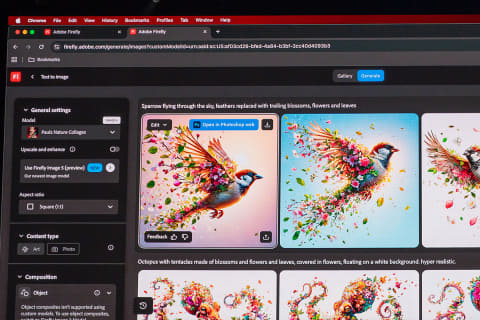

アドビは2023年春に独自のAIモデル「Firefly」を発表以降、Fireflyを戦略の軸に据えてきた。Fireflyは「Adobe Stock」に登録され、著作権面で問題のないデータで学習されている。その安心感を差別化要因にしてきた。

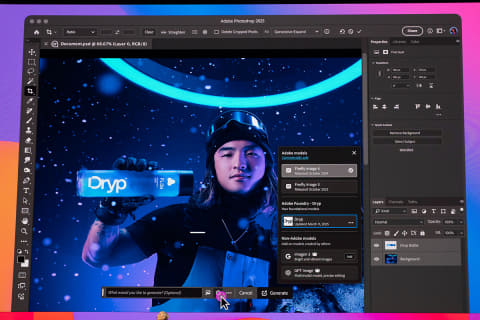

だがその方針は、今年の3月に変更された。アドビのツールを使いつつ、クリエイターの意思に基づき、他社のAIモデルを選択できるようになったのだ。

ただ、3月の発表時はそこまで注目されなかった。今年9月にPhotoshopの「生成塗りつぶし」機能でGoogleの「Gemini 2.5 Flash Image」(通称Nano Banana)に対応したところから脚光を浴び始めたように思う。Nano Bananaは画像生成のクオリティが高く、それだけ注目されたのだろう。

AIモデルで作品を作る場合、プロンプトから出力された画像。動画を使うだけでは足りない。それをさらに加工したり、逆に画像の一部をうまくAI生成物に入れ替えたりすることで、より実用的な使い方ができる。そうすると、PhotoshopやAdobe Expressなどの「もともと強力なクリエイティブツール」を持つアドビがさらに生成AIを組み合わせることは、大きな意味を持つことになる。

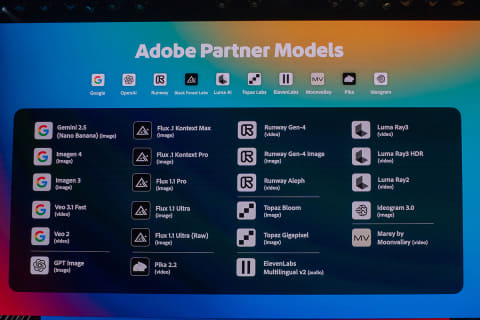

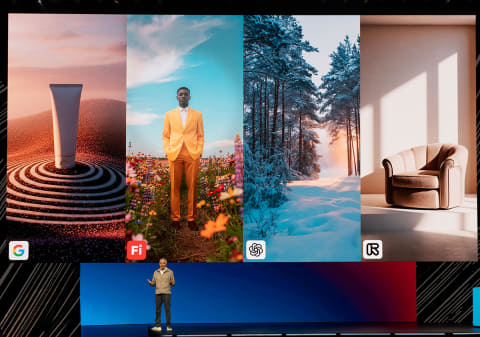

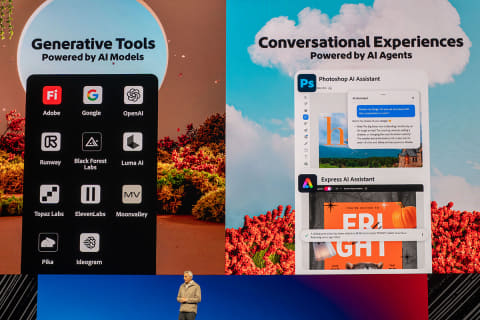

この方針は完全にアドビの基本戦略となった。Googleはもちろん、OpenAIやLuma AIなど多数のAIサービスプロバイダーと連携し、Photoshopなどのツール内から自由に選んで使える。

パートナーモデル戦略はクリエイティビティ強化のため

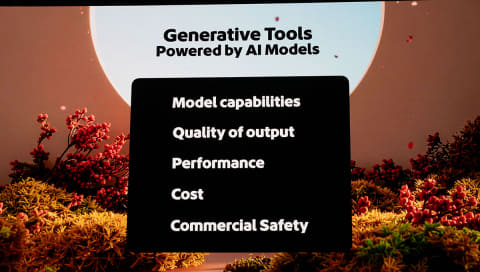

「選べる」理由は、それがクリエイターにとって自由度につながるからだ。

現在はAIモデルの進化と競争が激しい。ある日にベストな画質であったものを別の日に他のモデルが抜き去る……ということは十分にあり得る。

同時に、AIモデルによって向き不向きもある。

Luma AIの「Ray 3」は物理法則を含めた世界理解に優れる、とされている。FLUX.1は写実的な人物描写で定評があるが、絵画調のものを出力するは苦手、と言われている。

画質だけでなく、絵や動画を出力するのにかかるコストも違う。そして、Fireflyは権利面がクリアーで、ビジネスの中で使いやすいAIモデルであるのも間違いない。

それらをどう組み合わせるかは、まさにクリエイターの胸先三寸であり、クリエイティビティを広げる要素と言える。

特に大きいのは、アドビとGoogleが提携したことだ。

今後両社はAIに関してパートナーとなり、お互いの最新の技術やAIモデルを使える。例えばGoogleがNano Bananaの先にある新しいAIモデルを作ったとしても、アドビはそのAIをいち早く使える。逆にGoogle側は、アドビの最新アプリを使い、同社のAIモデルの最適化や機能連携を目指せる。

もちろんGoogleのAIモデル以外も使えるのは間違いないわけだが、Googleは有利な立場になるのは間違いない。

企業から個人まで「カスタムモデル」拡大

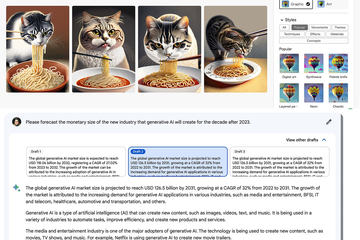

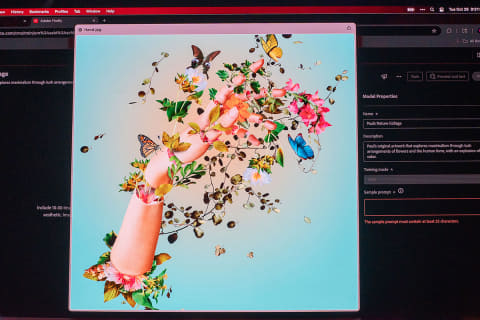

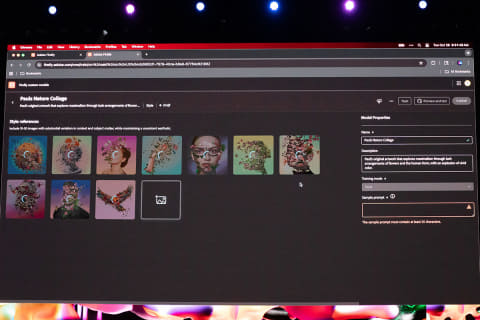

AIモデルについては、いろいろな企業が用意したものを使うだけではない。自分の作品から学習した「カスタムモデル」も使える。

企業のマーケティングツールである「Adobe Gen Studio」では、以前から「その企業のルールやトーン、マナーに合わせた生成AI」としてカスタムモデルが利用可能になっており、今回さらに、カスタムモデルの構築をアドビが請け負う「Firefly Foundry」というサービスも登場した。

ただそれらは個人向けでは、コスト的にも機能的にも使いづらい。そこでCreative Cloud向けでは、「自分の作品を集めて学習させる」ことで「自分の作品のテイストを持った形でのAIモデル」を作れるものが用意される。これが個人向けの「カスタムモデル」となる。

結果としてアドビのツールでは、「Firefly」「サードパーティーモデル」「Fireflyから作るカスタムモデル」の3パターンからAIを選んで作品を作れる、という形になる。

「支払いの形」もワンストップ

さらにもう一つ「ワンストップ」には意味がある。

それは、AIモデル利用料の支払いが「アドビ経由」になる、ということだ。

多数の生成AIサービスがあるが、それらすべてを契約している人はいない。だが自由にモデルを選ぶなら、どのサービスも使えるよう、契約しておく必要が出てくる。そうすると使用料は高くなるし、決済の複雑さも増す。

だがアドビの場合、Creative Cloud製品から使えるAIモデルの使用料は、すべて「アドビ製品向けの生成AIクレジット」から支払う。「Firefly Pro」や「Creative Cloud Pro」などのプランには生成AIクレジットが一定量提供されるから、使用量が極端に多くない限り、出費は抑えられる。

複数社のAIモデルが利用できて、支払いをまとめられるサービス自体は他にもある。まだ筆者の手元で比較するに至っていないが、アドビの生成AIクレジットコストが他社より極端に安い、ということはなさそうだ。

しかし、アドビのツールが使えることまでセットにすれば納得しやすい価格であることは間違いないし、Creative Cloud利用者にとって手軽であるのも間違いない。

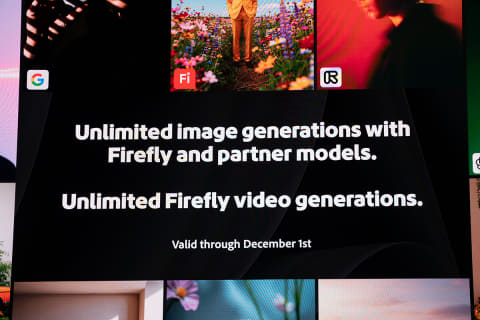

さらに、アドビは年内、大胆なキャンペーンを仕掛ける。

12月1日までの間、「Fireflyもしくはパートナーモデルを使った静止画の生成」と、「Fireflyを使った動画の生成」は無制限=実質無料になる。

「AIモデルを切り替えながらコンテンツを作る」という手法を理解してもらい、利用を定着させるには相当に有利なキャンペーンと言える。

多数ある「着実な進化」

AIへの取り組みは他にも多数ある。

Creative Cloud製品の機能改良としての部分はもちろん大きい。

Photoshopでは生成AIによるアップスケーリングが搭載され、Illustratorには平面に描いた物体を回転させる「ターンテーブル」機能も追加される。

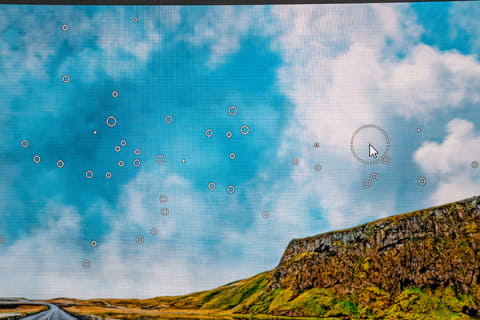

Lightroomでは「ノイズ除去」「生成削除」などの機能が劇的に高速化されるほか、カメラのセンサーやレンズに付着した埃に起因する写真の汚れを一括削除する機能などが搭載された。

Premiereは、動画内のオブジェクトを認識して素早くマスクする機能が入る。

なお、今回から正式にアプリ名が「Premiere」になり、「Pro」が外れる。だが、機能として放送や映画などのプロワークに使えるという要素に変更はない。

AIエージェントで「対話的生成」の世界に

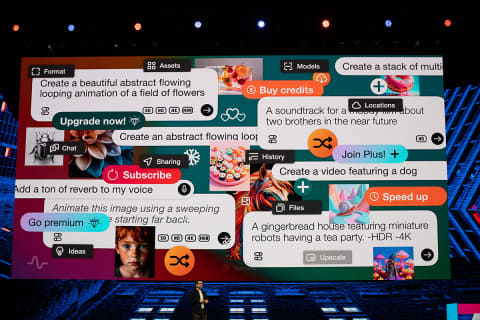

これらは日常的なクリエイティビティを高めるものだが、さらに使い勝手を上げるものとして「AIエージェント連携」が進む。

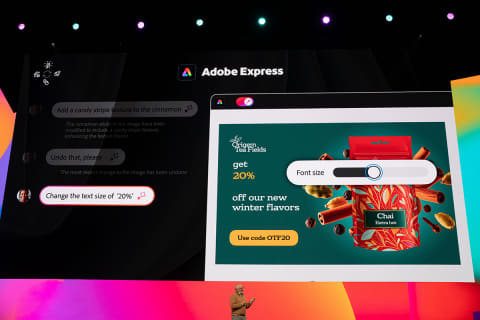

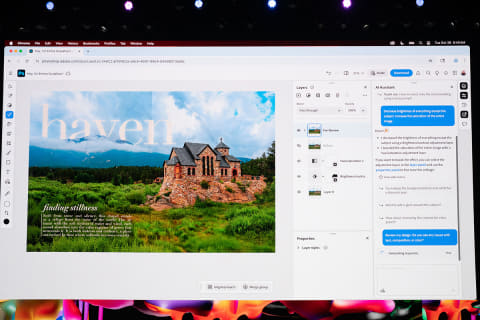

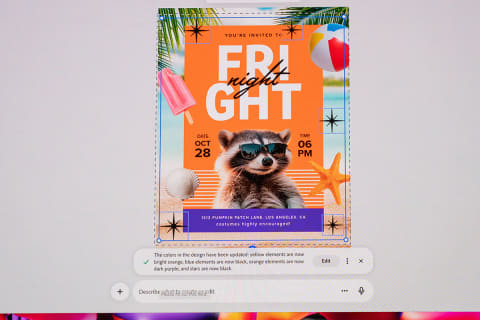

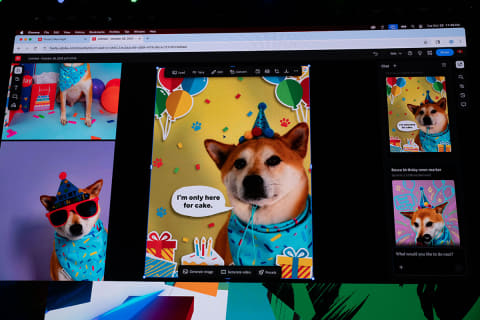

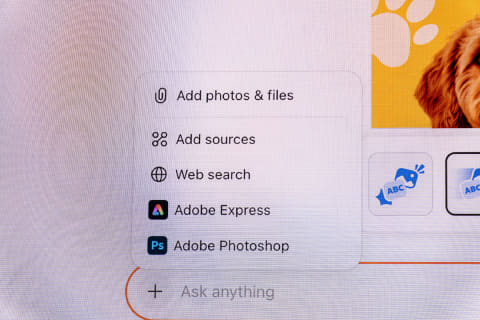

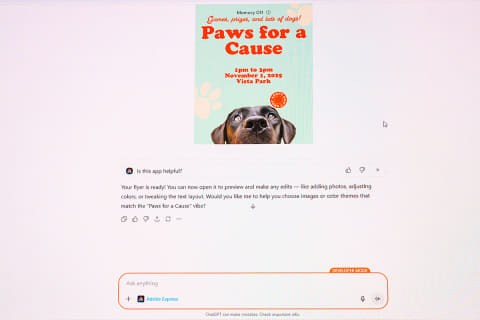

まずPhotoshopとAdobe Expressでは、「プロンプトによる編集」が行なえるようになる。1つ1つの操作を行うのではなく、文章で指示すると「やりたいこと」をソフトが持つ機能に合わせてAIが読み替え、自動実行する。

複雑な編集をするには機能の組み合わせを覚える必要があるが、プロンプトによる対話的な編集が可能になれば、機能を覚える量は減り、より創造的なアイデアに注力できる。

また、「修正の依頼」がメールでやってきた場合には、その依頼自体をプロンプトにコピペして作業させることで、修正作業を短時間で終了できる。

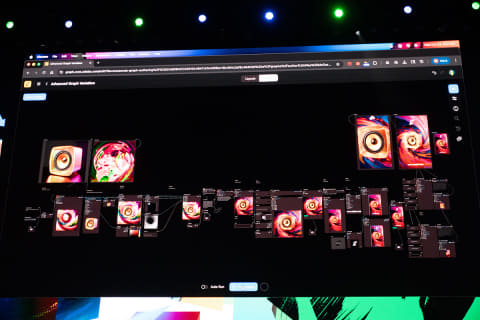

さらに、開発中の「Project Moonlight」ではアプリを跨いだプロンプトによる生成が行なえるし、「Project Graph」では、AIを含むワークフローを定義し、「最初の素材を変えれば、同じテイストの作品が生成される」という世界を目指す。

もう一つの「対話的生成」として、ChatGPTからAdobe Expressを使うデモも行われた。これもまた、チャットという作業の中で対話しながらCreative Cloudを使う姿でもある。

生成AIの凄みは「絵が生成される」ことではない。「作る側の思っている絵を生み出すツール」になることが、本質的な価値を生み出すためには必要だ。

AIモデル選択や機能進化と同時に、「対話的生成」=AIエージェントによる操作が実現されることでようやく、Creative Cloudの「生成AI対応」は次の段階に入る。

今回アドビが主張したかったのは、そういう世界なのだ。