西田宗千佳のRandomTracking

第630回

「AirPods Pro 3」最速レビュー。音質も使い勝手も進化。「ライブ翻訳」の仕組みとは

2025年9月15日 21:00

「AirPods Pro 3」の製品レビューをお届けする。

みなさんご存知のように、現行製品である「AirPods Pro 2」は大ヒットした。その後継であるPro 3が注目されないはずがない。価格も同じ(3万9,800円)で完全に入れ替わることになるが、どのくらい進化したのだろうか。

結論から言えば、「音質も使い勝手も劇的に上がった」。買い替えるかどうかはあなた次第だが、確実に「より良い製品」としてAirPods Pro 2を置き換えてきた印象だ。

ではどんなところが変わったのか、細かくチェックしていこう。

一見似ているが形状は変化。イヤーチップも専用品に

外観からいこう。

一見したところ、商品パッケージもイヤフォン・充電ケースも、大きく変化していないように見える。

AirPods 4がそうであるように、ペアリング用の物理ボタンがなくなっている。バッテリー残量を示すLEDも、内部に埋め込まれて目立たない形になっている。それ以外は、端子やスピーカーの穴、ストラップホールなどに変化はない。製品を片方ずつ持つと、違いに気づかない可能性は高い。

ただ、Pro 2とPro 3を並べて比較してみると、サイズが微妙に変化していることに気づく。

充電ケース自体は、Pro 3の方がちょっと大きくなっている。

同時に、イヤフォン自体も同じ形で同じサイズのように見えるが、形状が微妙に変化している。Pro 2のケースにPro 3のイヤフォンを入れることができないことからも、それはわかる。

見た目上の一番大きな違いは「心拍数センサー」が追加されていることだが、実際の使用感はもっと違う。耳への収まりが変化しているのだ。心拍数センサーを耳の皮膚に当てる関係もあるのだろうが、より広い面積で耳に接触するようになっていて、落ちづらさを感じる。

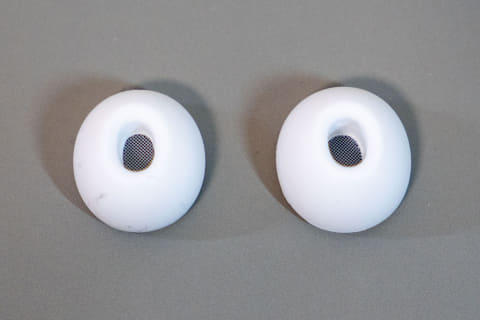

イヤーチップも変わった。

接続部の形状が変わっており、Pro 2までのものをPro 3で使うことはできない。

イヤーチップ自体はXXSからLまで5種類が付属する。サイズは少し小さくなった印象だ。例えば同じL同士であっても、Pro 3向けの方が小さい。

イヤフォン・イヤーチップの形が変わったことは、装着感を変える。落ちにくくなったという印象もあるが、同時に、耳の穴への負担も少し小さくなっている。これまで筆者はPro 2で「S」のイヤーチップを使っていたのだが、Pro 3では「XS」でもいいような気がする。この辺は個人差もあるだろう。

ANCも音質も向上、特にボーカルと空間オーディオに変化が

では結果として、聞こえ方がどう変わったのだろうか?

まず、アクティブノイズキャンセル(ANC)について。

Pro 2と比較すると、さらに低音が消えやすくなったと感じる。見た目にはあまり変化を感じないが、イヤーチップの内部にはフォーム材が充填されるようになった。その効果が大きいのだろう。

他のANC対応イヤフォンでも、イヤーチップにフォーム材を使って効果を高めるものは少なくない。Pro 2用のサードパーティー製イヤーチップでも、同様の効果を謳うものがある。Pro 3でも同じような効果があると感じられるが、同時に、耳への収まりの変化や、ソフト的な変更なども影響はしていそうだ。

次に音質。

これも変化が大きい。

AirPods Pro 2は、ヒット商品ということもあり、現在のANC対応イヤフォンのスタンダードと言える音質、と考えていい。市場において上位の音質ではあるが、違うキャラクター・より良い音質を謳う製品も増えている。

ただ、AirPods Pro 3はPro 2から大きな変化を遂げている。以下、Apple Music楽曲で試聴した結果をお伝えしていこう。

まず、解像感が一気に上がっている。

『BOW and ARROW』(米津玄師)や『IT'S MAGIC』(T-SQUARE)のようにキレが良い音が続くイントロでは、そのキレ感と細かな表現がより感じられるようになった。『The Fantastic Four: First Steps Main Theme Extended Version』での金管楽器の力強い音もより迫力がある。

特にボーカルの改善が著しい。

『君は天然色』(大瀧詠一)のように、煌びやかな演奏の中でのボーカルがより強く芯が立ったように感じられる。『Don't Stop Me Now』(クイーン)のような楽曲も、Pro 2よりPro 3で聴いた方が圧倒的に楽しい。

低音の厚みなどで他のイヤフォンの方が良い、と感じる部分もあるが、AirPods Pro 3は「Pro 2の特性を素直に伸ばし、解像感とボーカルの力強さを増したもの」という印象だろうか。ANCが音質に与えていた影響が改善され、全体的にさらに好ましい音になったという部分もあるのだろう。

もう一つ、顕著な変化があったのが「空間オーディオの自然さ」だ。

AirPods Proでは、ヘッドトラッキングを活かした空間オーディオに対応している。ステレオ楽曲の音場を広げたり、Dolby Atmosフォーマットで楽曲表現自体を高めたりする効果をもつ。

同様の機能を持つイヤフォンは増えており、空間オーディオ自体は珍しくなくなった。ただ、「自然な広がり」を実現している製品はまだ少ない。

AirPods Pro 2にしても、頭を動かした時、音場が一様に構成されているわけではなく、若干のゆがみはある。それはどのイヤフォンでも、多かれ少なかれ存在するものだ。

ただ、Pro 3ではそれがさらに自然になった。Dolby Atmos版の『Here Comes the Sun(2019 Mix)』(ビートルズ)や『Bohemian Rapsody』(クイーン)では、音場の広がりや各音源の位置関係、センターのボーカルの定位などで改善を感じた。

もちろん、ワイヤレスでのイヤフォンゆえに生まれる限界を超えるものではない。しかし、これだけカジュアルにしっかりした音質で、どこでも楽しめるというのは大きなことだ。しかも、これらの変化は「Pro 2と同じ価格でもたらされている」という点が重要だ。

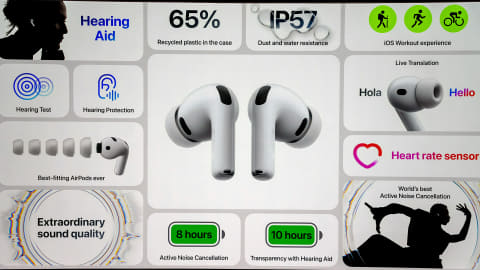

同時に、イヤフォン自体の動作時間も長くなっている。

AirPods Pro 2は、ANC動作時で「最大6時間」の再生が可能だったが、Pro 3ではそれが「最大8時間」になっている。国際線の飛行機内など、長時間の移動にはありがたい。

ただし、ケースを使用しての充電しつつ使った場合の動作時間は、Pro 2が「最大30時間」だったのに対し「最大24時間」(ともにANC利用時)に短くなった。

心拍数センサーは「フィットネス」アプリ向け

AirPods Pro 3は機能面での変化も大きい。

心拍数センサーを使ったワークアウト連携はその最たるものだろう。

Apple Watchなどのスマートウォッチには心拍数センサーを内蔵したものが多いが、AirPods Pro 3も同様の機能を持つ。

とはいえ、特質は少し違う。

Apple Watchは、装着中は常時心拍を計測する。内蔵しているセンサーは、緑色の可視光LEDと、非可視光の赤外線LEDを組み合わせたものだ。

それに対してAirPods Pro 3のセンサーは、非可視光の赤外線LEDを使っている。これはAirPods Pro 3のために開発されたもの。同じアップルのグループ会社であるBeatsの「Powerbeats Pro 2」も心拍数センサーを搭載しているが、あちらは緑色の可視光LEDを使うタイプ。ちょっとしたことだが、赤外線LEDだと、夜間でも耳から計測のための光が見えてしまうことがなく、目立ちにくい。

計測も常時行なうわけではなく、ウォーキングを含む「ワークアウトを行なっている時」の計測を前提としている。これは、イヤフォンの消費電力を考えると理解できる。

Pro 3はANC利用時なら最大8時間動作するが、心拍数センサーを使った場合には「最大6.5時間」と短くなる。ワークアウト時のみの計測にすることで、消費電力へのインパクトを減らしているわけだ。

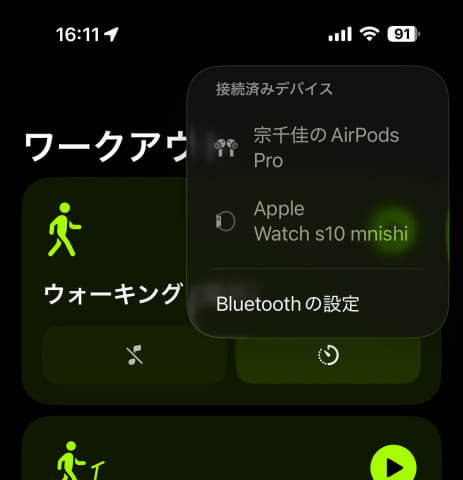

利用には、Apple WatchもしくはiPhoneとの連携が必須だ。Apple WatchとAirPods Pro 3だけをつけ、音楽や計測データ連携をApple Watchとともに行なうこともできれば、iPhoneと連携することもできる。iPhoneと連携する場合、Apple WatchとAirPods Pro 3双方の心拍を計測、それらの情報を統合して結果を残す。

心拍記録を使う時には、iPhoneもしくはApple Watchの「ワークアウト」アプリを使う。ワークアウトを始めると、その間の心拍数や消費カロリーや移動経路などが記録される。要は、Apple Watchを使って「ワークアウト」を行なったときと同じだ。ワークアウトを終了すると、計測も止まる。

以下は実際にウォーキングをした時のもの。AirPods Pro 3を使った時のデータも、Apple Watchを使った時のデータも大差なく計測できているのがわかる。

音楽を聴きつつワークアウトをする人には、Apple Watchの使用以外にも選択肢が増えた……と考えるのが良さそうだ。

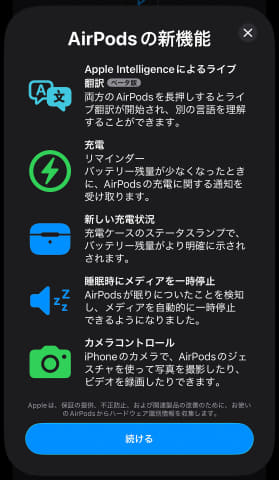

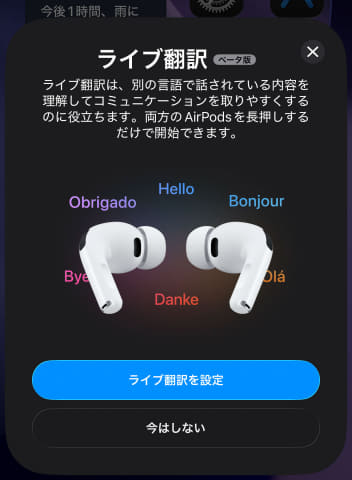

Apple Intelligenceを使った「ライブ翻訳」

もう1つ、機能としての大きな変化が「ライブ翻訳」だ。

この機能は、対話中の相手との間で、いわゆるリアルタイムでの通訳を実現するもの。これまでもスマホアプリを見せる形では行なえていたが、AirPodsをつけた状態で、翻訳を音声で聞ける。イメージとしては、ニュースなどで見る「同時通訳」に近い。以下のプレゼン動画でイメージを掴めるが、試してみたところ、実際まさにこの通りに動作した。

より深く理解するために、動作の仕組みを解説しよう。

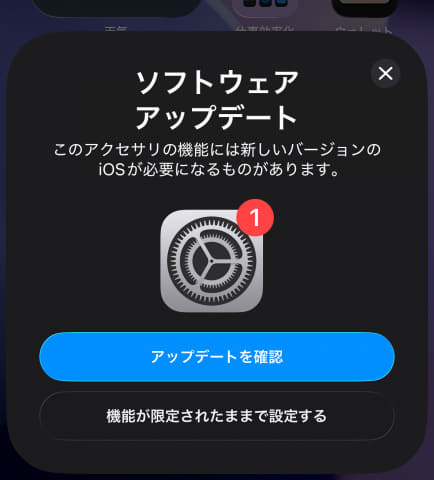

ライブ翻訳は、iPhone上のオンデバイスAIであるApple IntelligenceとAirPodsが連携する形で実現する。すなわち、以下の条件がセットである必要がある。

- iOS 26にアップデートしていること

- Apple Intelligence対応のiPhoneであること

- AirPods 4、AirPods Pro 2、AirPods Pro 3を使っていること

要はAirPods Pro 3固有の機能ではないのだが、Apple Intelligence対応のiPhoneは必須になる。Apple Intelligenceはデバイス上で動作するので、ネットワークへの接続は必須ではない。すなわち、通信が使えない場所でも動作する。

誰かを相手に2人で話すとしよう。

相手の声は、基本的には自分がつけているAirPodsからiPhoneへと伝えられる。特別な設定をしない限り、iPhoneのマイクを使うわけではない。

なぜなら、ここでは「相手の声を正確に拾いたい」からだ。

AirPodsにはヘッドトラッキング用のセンサーがある。これとAirPods用のマイクを組み合わせ、「自分の正面にいる相手の声」を正確に拾う仕組みが使われている。当然ながら、自分の声もAirPodsから拾う。

iPhoneはApple Intelligenceで翻訳をして音声を合成、AirPodsへと流す。

だから、ライブ翻訳時にiPhoneを手に持っている必要はなく、ポケットやカバンの中にしまっておいてもいい。

ただこの時、相手の声と翻訳が同じ音量だと聞きづらくなる。

ライブ翻訳中はAirPodsの「外部音取り込みモード」になっているが、同時に、相手の現実声の音量を下げ、その上に翻訳音声をボイスオーバーする形になる。結果として、相手の言葉が目的の言語に変換されて聞こえる……という仕組みである。

双方がiPhoneとAirPodsを使っている場合、この機能を双方が使うことになるので、お互いの話している内容がAirPodsから聞こえる。特に両者が通信しあって翻訳しているのではなく、「相手の言葉が翻訳されて聞こえるもの同士で話している」という話にすぎない。

片方がiPhoneとAirPodsを使っていない、要は普通に話している場合には「自分の話声の翻訳が相手に聞こえない」わけで、そのために、iPhoneを相手に見せて対話する。

仕組みがわかってみれば、意外とシンプルなものだ。

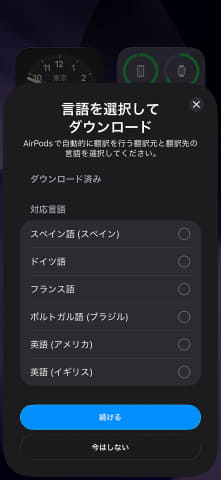

翻訳はオンデバイス、AIモデルのダウンロードが必要

筆者も試してみたが、かなり面白い。

使うには、該当する言語のAIモデルを先にダウンロードしておく必要がある。1言語なら数百MB程度である。

現状はAIモデルに「日本語」がないため、日本語での翻訳はまだできない。しかし年内には、日本語を含むAIモデルも提供され、翻訳可能になる予定だ。

今回取材中、特別に「日本語版」での翻訳を体験できた。精度は完璧ではないし、相手が話し始めてから1、2秒のラグがあって翻訳が始まる。とはいえ、これだけのことが簡単にできてしまうのは驚きであるのは間違いない。

英語⇔スペイン語で翻訳するときに比べると、ラグや精度は落ちるように思う。ただそれは、英語とスペイン語が「似た語順・文法」の言語であるから……という事情が大きい。英語⇔日本語や英語⇔韓国語などは、語順・文法の問題から、リアルタイム翻訳にリスクがある。これはどこの翻訳機能も同様だ。

その中では、アップルのライブ翻訳は、単純な翻訳の質よりもラグの小ささを重視しているように思えた。将来的に日本語⇔韓国語でのライブ翻訳ができるようになれば、文法が似ているのでラグも質もより良いものになるだろう。

スマホで翻訳、というアプリはたくさんあり、翻訳という機能自体が珍しいわけではない。他のスマホでも、オンデバイスAIをアピールする目的から、多数の翻訳機能が発表されている。

それらに対する利点は、「自分の側はAirPodsで確認するので体験が良い」ということになる。相手がライブ翻訳を使っていない場合にはiPhoneを見せる必要があるが、その辺は現実解という話ではある。

前出のように、ライブ翻訳ではAirPodsを細かく制御して使い勝手をあげている。汎用のBluetoothヘッドフォンでは必要なコントロールが行なえないので、現状では使えない。アップルはこの体験自体を差別化要因にしており、そのためにはOS・ハードウエアの統合が有利……という判断をしているわけだ。

ハードを購入する必要はあるが、ライブ翻訳自体に別途費用はかからない。

ライブ翻訳は現状まだ珍しい機能だが、今後はスマホにとって当たり前の機能になり、「翻訳サービスだけで収益を得る」のが難しい時代になっていきそうだ。消費者にとってメリットである一方、翻訳サービスやアプリを提供するライバルにとっては厳しい話でもある。