西田宗千佳のRandomTracking

第632回

新スマートグラスから「メタバースのAI生成」まで。Meta Connectでの発表を速報

2025年9月18日 10:30

Metaは9月17日・18日(アメリカ西海岸時間)の2日間に渡り、同社の開発者会議「Meta Connect 2025」を開催中だ。

基調講演では様々な新製品・新技術が発表されている。ここではまず、それらをご紹介したい。

目玉となったディスプレイ内蔵スマートグラス「Meta Ray-Ban Display」については、まず外観を中心にお伝えする。体験レポートは、Metaマーク・ザッカーバーグCEOの基調講演分析とともに、のちほど別の記事としてご紹介する予定なので、少々お時間をいただきたい。

ディスプレイ付きのスマートグラス登場

今回最大の発表が「Meta Ray-Ban Display」だ。価格は799ドルで、アメリカで9月30日から発売。日本での展開は未定。

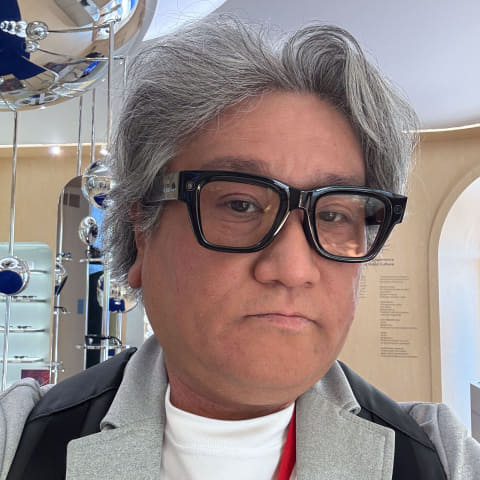

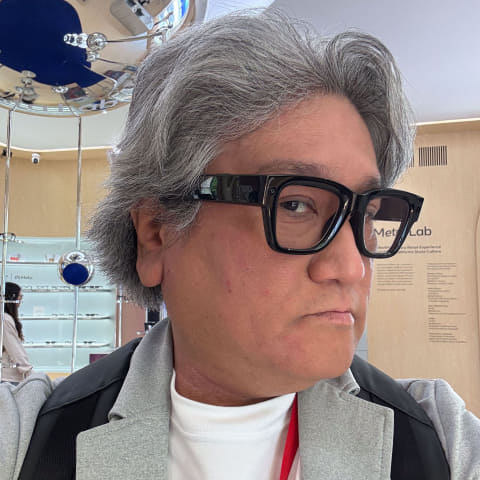

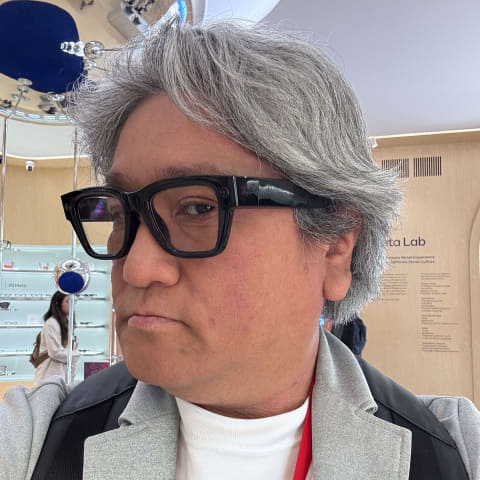

デザインの詳細を見ていこう。記事を書いている段階では、「実機と同じものだが電源を入れていないもの」の撮影だけが許された。

見た目は「ちょっとフレームがゴツいメガネ」といった感じ。重量は70g台だそうで、現行のRay-Ban Metaより重い程度。普通のメガネの倍よりは軽い。サングラス型ディスプレイの「XREAL One」が82gなので、それと同じくらいだろうか。

Ray-Ban Metaと同様に単眼のカメラとインジケーターがあり、ディスプレイは右目側にのみある。本体に搭載されているのは電源と写真のキャプチャボタンというシンプルな構成で、情報は基本的に、連携したスマホから提供される。

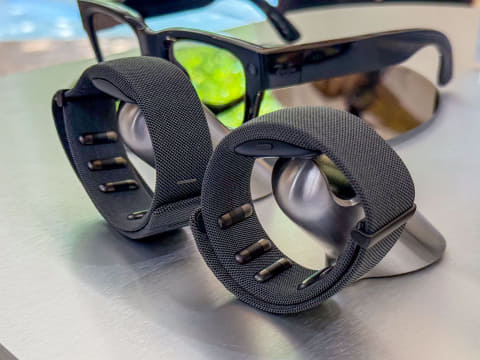

セットで使うのは、腕につけるEMG(ElectroMyoGraphy=筋電位)コントローラー。筋電位から「腕や指がどう動こうとしているか」を読み寄り、小さな動きで操作する。親指と人差し指を合わせて「タップ」、親指と中指だと「バック」、ボリュームをひねる動作で音量調節……といった具合だ。

これらの要素は、昨年のMeta Connectで発表された「Orion」に似ている。

ただし、OrionとMeta Ray-Ban Displayは違うものだ。OrionがARグラスであるのに対し、Meta Ray-Ban Displayは「目の前に通知や地図などの情報が出るデバイス」になっている。

右目にはカラーのLEDプロジェクターが仕込まれ、ウェーブガイド技術を使って目まで届けられる。以下の写真に青い線が見えると思うが、これが目へと光を導くウェーブガイドだ。屋外でもある程度十分な明るさを実現しているという。

ただ、仕組みから考えると、視野はそこまで広くない上に、片目への映像なので立体感はない。その点がOrionとは大きく異なる。

要は情報だけを表示する「情報系スマートグラス」なのだ。

この辺、実際に使うとどんな使い勝手になるのかは、後日掲載する体験レポートをお待ちいただきたい。

Ray-Ban Metaは「Gen 2」に。

Metaは今年、スマートグラスに注力している。Meta Quest向けの新作ゲームや新技術も発表されたのだが、Meta Questシリーズのハードウエアにアップデートはない。

今回発表されたハードウエアは、前掲のMeta Ray-Ban Displayと、2つのスマートグラスだ。

2023年末にMetaは、カメラとマイクを搭載し、スマホと連携するスマートグラス「Ray-Ban Meta」を発売。日本では販売されていないものの、アメリカを含む多くの国でヒットを飛ばしている。製品レビューは以下に掲載している。

今年の前半に、オークリーをパートナーとした「Oakley Meta」も発売済みだが、「Ray-Ban Meta」も「Gen 2」に進化した。機能自体は、これまでのモデルと大きく変わらない。

Gen 2は379ドルから。本日から出荷開始。変更点は、バッテリー動作時間が2倍(最大8時間動作)となり、搭載カメラが3K(3,024×4,032ドット)に変わった。

これはOakley Metaで進化した内容を、そのままRay-Ban Metaにも反映したのがGen 2、といって差し支えない。

カメラが3Kになったことで、従来は1080pだったビデオ撮影も…

- 1200p/60 FPS (3分まで)

- 1440p/30 FPS (3分まで)

- 3K/30 FPS (3分まで)

…に進化し、かなり画質が上がった。どんな動画が撮れるかは、もう1つの新製品の方で示す。

もう1つの製品が「Oakley Meta Vanguard」だ。

こちらはゴーグルタイプで、よりアクティブなスポーツ向けの製品になっている。機能自体は基本的に他のモデルと同じだが、ヘルメットと一緒に使っても邪魔にならないようなデザインであり、ボタン類もすべて下側から使えるようになっている。

どんなビデオが撮れるかは、以下のサンプル動画をご覧いただきたい。

新機能として説明されたのが、ガーミンのスマートウォッチと連動する機能だ。心拍や移動量などをスマートウォッチで計測、Metaのスマートグラスで撮影している生映像に重ねて表示できる。

リアルタイム連携はガーミンだけで可能だそうだが、スマートウォッチなどの情報との連携自体は、アップルの「HealthKit」やAndroidの「Health Connect」といったスマホOSの健康管理情報とは連携可能。事後にデータを使って動画とともにチェックする……ということは可能だそうだ。なので、他のスマートウォッチを使っている人も無意味というわけではない。

メタバースを「生成AI」で作る

前出のように、今年はMeta Questシリーズのハードウエア刷新はなかった。だが、MetaがVRやメタバース事業を諦めてしまったわけではない。「Marvel's Dead Pool VR」や「Star Wars: Beyond Victory」、「Demeo x Dungeons & Dragons:Battlemarked」といったゲームのアナウンスもあった。

同時に力を入れていたのが、同社のメタバース「Meta Horizon World」についてのアップデートだ。

同社は2021年に「Meta」へ社名変更し、メタバースへの注力をアピールしてきた。ただ、仮想空間の中で過ごすというアプローチはまだ広がりきっていない。RobloxやVRChatなどのプラットフォームを熱狂的に支持し、そこで過ごす人々は増えているものの、誰もが仮想空間を毎日使う……とまではいかない。Metaのデバイスは広く使われているが、Metaのメタバースが強く支持されているわけではない。

そこにテコ入れとして登場した技術が2つある。

1つは、メタバース構築用のエンジンである「Meta Horizon Engine」だ。

メタバースには、CGで作った背景やキャラクター、そしてそれらを制御するスクリプトに音声データなど、様々な要素が必要になる。要は3Dのゲームを1から作るような努力とノウハウが必要になるわけだ。

ゲームを作れるくらいの機能があるが、それを使いこなせる人は少ない。

そこでMetaは、Meta Horizon Engineと生成AIを組み合わせた。プロンプトで指示するだけで、風景からキャラクター、ゲームを実現するためのスクリプトまで、全ての要素を自動で生成できる。気に入らない部分があったら、プロンプトで指示して作り直せばいい。

この要素は、2年前にMetaのCTOであるアンドリュー・ボスワース氏にロングインタビューした時に出てきたものだ。彼は『スタートレック・ネクストジェネレーションズ』に登場する「ホロデッキ」に例えていた。

前掲のビデオではリアリティを感じないかもしれないが、撮影しないことを条件に体験できたデモでは、PC上でプロンプトを書くだけで、数十秒でワールド自体がファンタジーからポスト・アポカリプス世界へと切り替わった。もちろん、用意しておいたデータを切り替えたわけではない。その場で、クラウド上でMetaのAIを使って生成していた。

そうやって作ったメタバースのワールドを簡単に公開し、他の利用者に入ってきてもらって楽しむ……という世界を想定しているわけだ。

現実世界をMeta Quest 3+数分の時間で3Dデータに

もう一つ大きいテクノロジーとして公開されたのが「Hyperspace」という技術だ。

まずは以下の動画をご覧いただきたい。

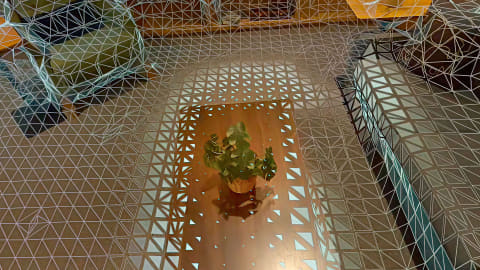

これは、Hyperspaceを使って実空間をメタバース化したものだ。実際HMDをかぶり、この中を歩き回れる。

3Dで世界をキャプチャする手法としては「ガウシアン・スプラッティング」という技術がある。Hyperspaceもその1つだが、目の前の風景がとにかく精細かつリアルに再現できるのが特徴だ。

Hyperspace自体は昨年のMeta Connectで公開されており、体験デモもMeta Quest 3でダウンロードして楽しめる。

だが今年はさらに、「自分で好きな空間をキャプチャする」ことが可能になった。

Meta Quest 3をかぶって、キャプチャしたい部屋の中を歩き回って見渡すだけで、前掲のような、現実にかなり近い形での3Dデータ化ができる。キャプチャにかかる作業時間は本の数分。筆者もやってみたが、5、6分で終わった。

そこからはデータをクラウドにアップロードしてAIが数時間処理したのち、実際にダウンロード可能になる。

キャプチャ用アプリは無料でMeta Questユーザー向けに、本日から公開される。まずはアメリカ市場から公開されるが、日本を含む他の地域についても、「さほど遅れることなく公開されるのではないか」と担当者は話す。だから、Meta Questを持っている人なら、自宅などをキャプチャして試すことも可能だ。

現在はテスト段階のため、キャプチャした空間のデータは自分だけがみられる。

しかし今後、HyperspaceはMeta Horizon Engineと連動し、Horizon Worldで公開し、他人に体験してもらうことも、その中で暮らすことも可能になる。

当然、Meta Horizon Engineの生成AI機能とも連動可能なので、「現実にはない家具をAIで作って配置する」といったこともできるという。

この技術はゲームなどに使えるのはもちろん、建築や不動産など、多くの可能性を秘めている。

これらの施策は、Metaが継続して開発してきたAIとメタバースを掛け合わせたものだ。

メタバースの課題である「世界のデータを誰が、どうコストをかけて用意するのか」という部分について、Metaは「AIにやらせる」という答えを出してきた。

交わらないように見えた2つの施策は、まさに今年一体化して目の前に現れてきた。

この辺については、また、マーク・ザッカーバーグCEOなどの取材を加味し、詳しくレポートする予定だ。