西田宗千佳のRandomTracking

第633回

Metaが問うディスプレイ内蔵AIグラス「Meta Ray-Ban Display」、実機体験からわかること

2025年9月18日 16:28

Metaがディスプレイ内蔵AIグラス「Meta Ray-Ban Display」を発表した。

すでに外観や、Meta Ray-Ban Display以外の新製品については記事を掲載している。

その後実機を体験できたので、その内容について詳報する。

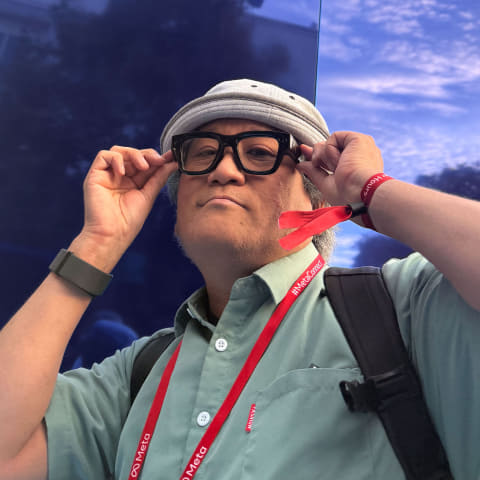

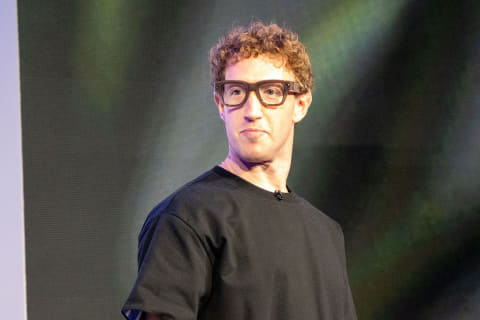

ザッカーバーグCEOも装着して登壇

「10年以上にわたって開発してきたものであり、他では見たことのない特別な製品です」

Metaのマーク・ザッカーバーグCEOは、そう語ってMeta Ray-Ban Displayを紹介した。実は冒頭からこの製品をかけて登場し、どんな映像が見えるかをデモしながら基調講演は進んでいた。

価格は799ドルで、アメリカ市場から販売。店頭でデモを体験、視力調整レンズなどを組み合わせた上での販売となる。

2026年初頭には、カナダ・フランス・イタリア・イギリス市場へと、特定のメガネ販売パートナーと組んで販売していく予定だという。開発に携わる関係者は「可能な限り広く様々な国で販売したい」という意欲を持っていると話すが、残念ながら、現時点では、日本市場への投入予定は言及されていない。

本製品は、基本的にはスマートフォンの周辺機器だ。AndroidとiOS、どちらにも対応している。スマホの上で専用アプリを動かし、さらに、メガネ本体に加え、セットで販売されるEMG(ElectroMyoGraphy=筋電位)コントローラーである「Meta Neural Band」と組み合わせて使う。スマホとの間は、Wi-FiとBluetoothを組み合わせて通信する。

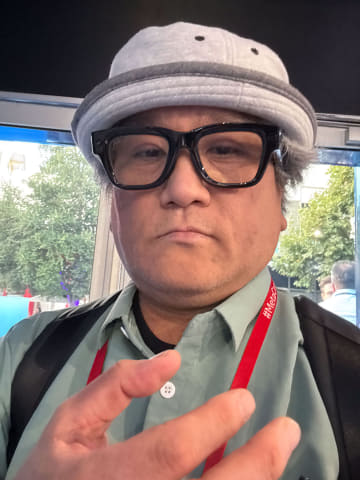

形状としては「ゴツいメガネ」という感じで、意外と違和感はない。カラーは写真にあるBlackと、ザッカーバーグCEOもつけていた「Sand」の2種類。

充電用のケースと組み合わせるところや、メガネにカメラ・マイク・スピーカーが搭載されているところは、ディスプレイのない「Ray-Ban Meta」に似ている。

ただし、Meta Ray-Ban Displayのケースは、メガネを収納していない時には折り畳んで小さくできる構造となっている。

Ray-Ban Metaにディスプレイを搭載

MetaのAIグラスである「Ray-Ban Meta」は、スマホ上のアプリ「Meta AI」と連動して動く。音声でAIに質問し、音声で回答を得る。搭載しているカメラで「見た目・一人称視点」の写真や動画を撮影、シェアできる。

日本では販売されていないのでピンと来ないかもしれないが、アメリカを中心にヒットしており、スマホと連携する「次の存在」の本命になってきた。

Meta Ray-Ban Displayは、Ray-Ban Metaの兄弟モデルだ。違いは名前にあるように「ディスプレイ」があることだ。

以下の写真は、基調講演でのデモで示されたものだ。

予定を表示し、相手の話すことを文字に書き起こし、撮影した写真や動画を画像で確認する。カメラのズーム機能もある。

これを実現しているのは、メガネのヒンジ部分に仕込まれた、小型のカラーLEDプロジェクターである。

その光をレンズ部に仕込んだ「ウェーブガイド」で目の中まで届ける。以下の写真中央に、青い線のようなものが見えるだろうか。これがウェーブガイドだ。

表示はかなり鮮明で、驚くほど解像感がしっかりしている。

Metaの資料によれば、プロジェクターは600×600ドットの正方形。それが視野に入ると、視度1度あたりに42ドットで構成される「42PPD」の解像感になる。600×600ドットはスマホなどと比べると小さな領域に過ぎないが、42PPDあると、実際の見た目にはドット感の薄い、緻密な映像に見える。

以下は、実際にかけてみた時の画像だ。撮影の関係で色がおかしくなっているが、その点はご了承いただきたい。実際にかけて目で見た時の色は、基調講演でのデモと同じく、ちゃんとした自然なRGBだ。

実際のデバイスで撮影した映像は、視野の中央に四角い領域があるように見える。実際この通りで、Meta QuestやApple Vision Proのように視野を覆うわけではない。スペックによれば、映像の視野は20度だという。

製品名が「Meta Ray-Ban Display」であり、「AR」や「MR」などの言葉がないのはこのためだ。

Meta Ray-Ban Displayはあくまで、スマホの上にある専用アプリが作り出した映像を「視界の特定の場所に表示するディスプレイを搭載した機器」である。

だから、いわゆるARやMRのような表現ではないし、「XREAL One」のような空間にディスプレイを配置するものでもない。情報やアプリを視界に表示する「情報ディスプレイを搭載したAIグラス」なのだ。

昨年のMeta Connectで発表された試作ARデバイス「Orion」と似たデバイスは使っているが、AR機器であるOrionとは似て非なる存在である。

「コントローラー」の存在が他との差別化点

この種の「情報表示型のスマートグラス」は他にもある。

Meta Ray-Ban Displayの違いは、スマホの通知などを「表示するだけ」ではなく、複数のアプリを画面内で動かすことにある。

以下は、スマホ上にMeta Ray-Ban Displayの表示している画面が表示されたものである。おそらくはデモ用と思われる。

左側は操作のチュートリアルを兼ねたゲームで、右側はメインメニューだ。

Meta Ray-Ban Displayには、視線操作や指先の位置を認識する機能はない。要は、マウスなどと同じような「ポインティングデバイス」が存在しないわけだ。

そこで出てくるのが「Meta Neural Band」だ。

Meta Neural Bandは、指先の細かな動きを腕の筋電位から読み取る。あくまで「指先の動き」であって「指の位置」ではない。

親指と人差し指を打ち合わせると「タップ」、親指と中指だと「キャンセル」や「バック」という動作になるが、もっと多彩な動きを読み取る。

例えば、親指を人差し指に沿って左右に滑らせる動作は「メニューの左右移動」になり、親指を上下に滑らせる動きは「メニューの上下移動」になる。

指先で「つまみを持って回す」ような動きをすると、音量などの「ボリューム調整」になる。カメラが捉えている映像を「ズーム」するときもこの動きになる。

スマホやPCのアプリを自由に操作するのとは違うが、ちょっとしたメニューの選択には十分な機能を持っている。

以下は、音楽プレイヤーを操作している時の筆者の指の動きだ。捻っている時にはボリュームを、それ以外の時はメニューを選んでいると思えばいい。

そもそも、この操作は腕がどこにあっても使える。

手を膝や机の上に置いて操作してもいいし、ポケットの中に手を入れたまま操作してもいい。だから腕を空中にあげて操作する必要はなく、疲れを感じづらい。

AI連携で色々な用途に

そうやって操作する中でも特別な機能になるのが、「Meta AI」に絡む機能だ。

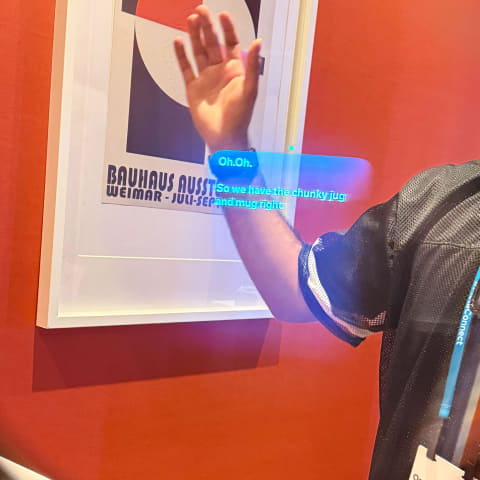

体験できたデモの中には、目の前にあるイラストやオブジェについてMeta AIに聞く……というものがあった。

これらの場合にはMeta Ray-Ban Displayのカメラが自動的に写真を撮り、マルチモーダルAIによって画像を解析し、音声とテキストで答えを返してくる。

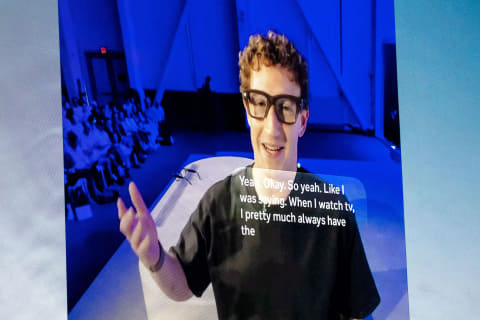

また、相手の話す声を書き起こす「ライブトランスクリプト」のデモでは、目の前の相手の声だけを把握し、文章としてほぼリアルタイムで表示していた。そこにAIの翻訳機能を噛ませれば「リアルタイム翻訳」になる。どんな風に見えるかは、以下のビデオをご覧いただきたい。

この他にも、Spotifyを再生する音楽プレーヤー機能や、撮影した写真や動画を見る機能もあった。デモで体験することはできなかったが、スマホなどとビデオ通話をやりとりすることもできる。

現状では「いくつかの有用な機能が組み込まれている」状況で、Meta Neural Bandの操作でそれらの機能を呼び出す……という形であるように思えた。独自のアプリを作って利用できるかどうかは、現時点では確認できていない。

製品として最も似ているのは、5月にGoogleが発表した「Android XR搭載デバイス」のうち、スマートグラス型のものがそれに当たる。おそらく狙いも機能も近い。

だが、Meta Neural Bandがあって色々な操作がしやすい……というのが差別化点だろうか。

そして、この種のデバイスとしては「最初の製品から価格が抑えられている」点も大きい。

カラーの精細なディスプレイを搭載し、コントローラーがついて800ドル(約11万8000円)というのは、お手軽……というには高いが、体験としてはかなり安い。

Metaは相当の開発期間をかけて、「普及前段階から、かなり低価格にAIグラスを開発して販売する」という形を実現したのだ。